Experimente¶

Lernen Sie, Ihre LLM-Anwendungen systematisch zu testen und zu vergleichen

Experimente helfen Ihnen dabei, verschiedene Prompts systematisch zu vergleichen, ihre Effektivität zu bewerten und die Leistung im Zeitverlauf zu verfolgen. Sie sind die Grundlage für datengetriebene LLM-Entwicklung und ermöglichen es Ihnen, mehrere Varianten zu testen und zu analysieren, welche für Ihren spezifischen Anwendungsfall am besten funktioniert.

Was ist ein Experiment?¶

Ein Experiment kombiniert mehrere Schlüsselkomponenten, um eine systematische Evaluierung zu erstellen:

- Prompt Template - Die Grundlage mit Ihrem Prompt und

{{Variablen}} - Collection - Eine Reihe von Test-Eingaben (Template-Variablen), die verschiedene Szenarien repräsentieren

- LLM Config - Die Modellkonfiguration (Anbieter, Parameter, etc.)

- Criterion Set - Evaluationskriterien, die definieren, was eine gute Antwort ausmacht

Wenn Sie ein Experiment ausführen, generiert elluminate Antworten für jede Eingabe in Ihrer Collection und evaluiert dann automatisch jede Antwort anhand Ihrer Kriterien.

Ihr erstes Experiment erstellen¶

Schritt 1: Zu Experimenten navigieren¶

Gehen Sie in Ihrem Projekt zur Experiments-Seite. Sie sehen Ihre Liste der Experimentausführungen mit Optionen zum Erstellen neuer Experimente oder zum Anzeigen der Timeline.

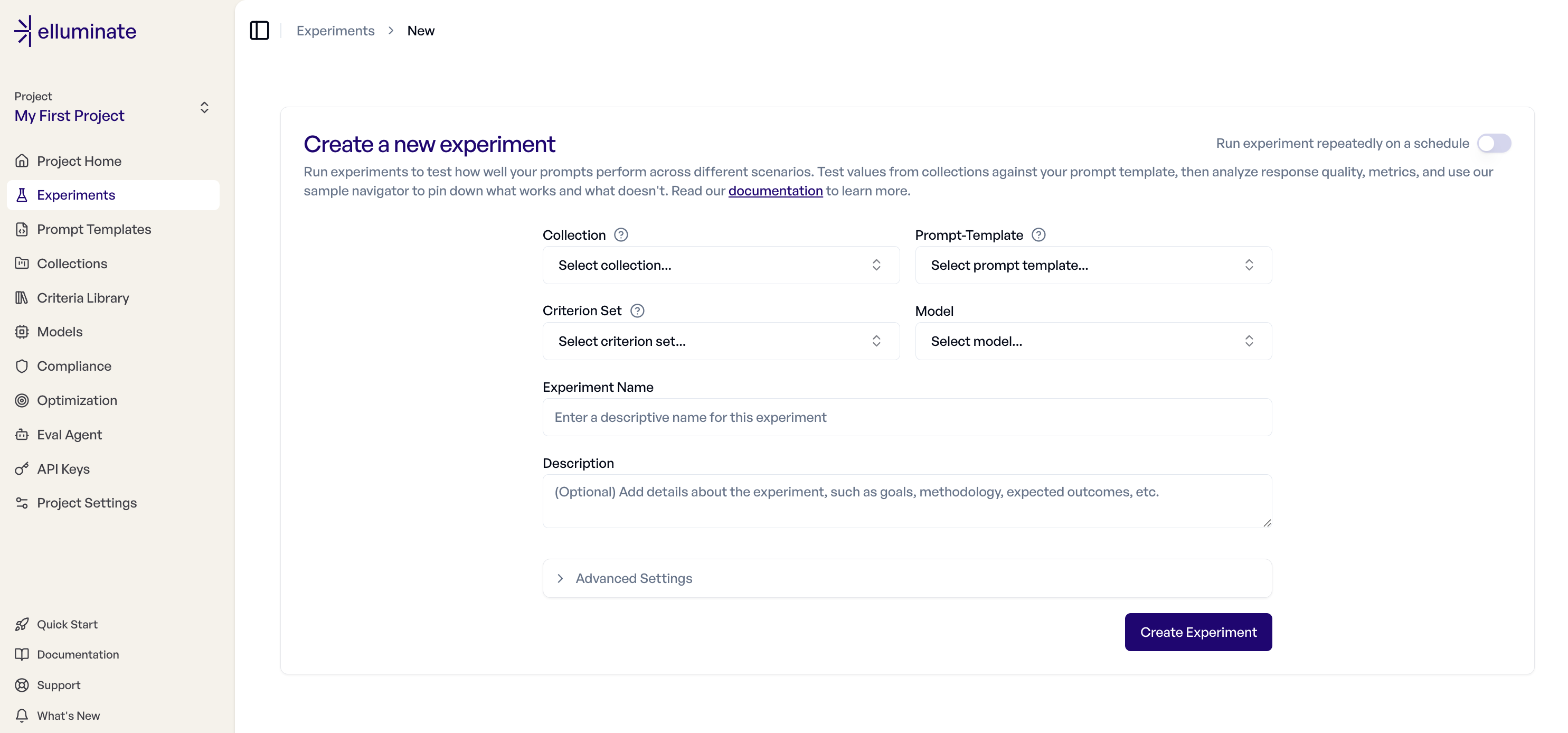

Schritt 2: Neues Experiment erstellen¶

Klicken Sie auf "New Experiment", um den Dialog zur Experiment-Erstellung zu öffnen. Sie konfigurieren:

Grundeinstellungen:

- Collection - Wählen Sie Ihren Test-Eingaben-Datensatz

- Prompt Template - Wählen Sie Ihr Template mit Variablen

- Criterion Set - Kriterien zur Bewertung der Antworten

- Modell - Wählen Sie, welche LLM-Config für die Antwortgenerierung verwendet werden soll

- Experiment Name - Aussagekräftiger Name für dieses Experiment

- Beschreibung - Optionale Details darüber, was Sie testen

Kompatibilitätsregeln

Das System bietet nur gegenseitig kompatible Collections, Prompt Templates und Criterion Sets an. Wenn Ihre gewünschte Auswahl nicht erscheint, überprüfen Sie Ihre Platzhalter und Spaltenbenennung auf Probleme.

Erweiterte Einstellungen

- Rating Mode - Der Detailed-Modus enthält Begründungen für jedes Kriterium und wird für bessere Interpretierbarkeit empfohlen. Der Fast-Modus liefert nur Bewertungen ohne Erklärungen und kann etwas schneller sein.

- Epochs - Epochs ermöglichen es, dieselbe Evaluierung mehrfach auszuführen. Dies macht die Statistiken zuverlässiger, kann aber einige Zeit in Anspruch nehmen.

- Rating Version - Wählen Sie die Rating-Modell-Version zur Bewertung der Antworten. Standardmäßig wird die in Ihren Projekteinstellungen festgelegte Version verwendet.

Schritt 3: Das Experiment ausführen¶

Nach dem Klicken auf "Create Experiment" wird elluminate:

- Antworten generieren - LLM-Antworten für jede Test-Eingabe erstellen

- Antworten bewerten - Jede Antwort anhand Ihrer Kriterien evaluieren

- Ergebnisse berechnen - Gesamtscores und Kriterien-Performance berechnen

Sie können den Fortschritt in Echtzeit von der Experiment-Detailseite aus überwachen.

Experimentergebnisse verstehen¶

Sobald Ihr Experiment abgeschlossen ist, können Sie die Ergebnisse in zwei Hauptansichten analysieren:

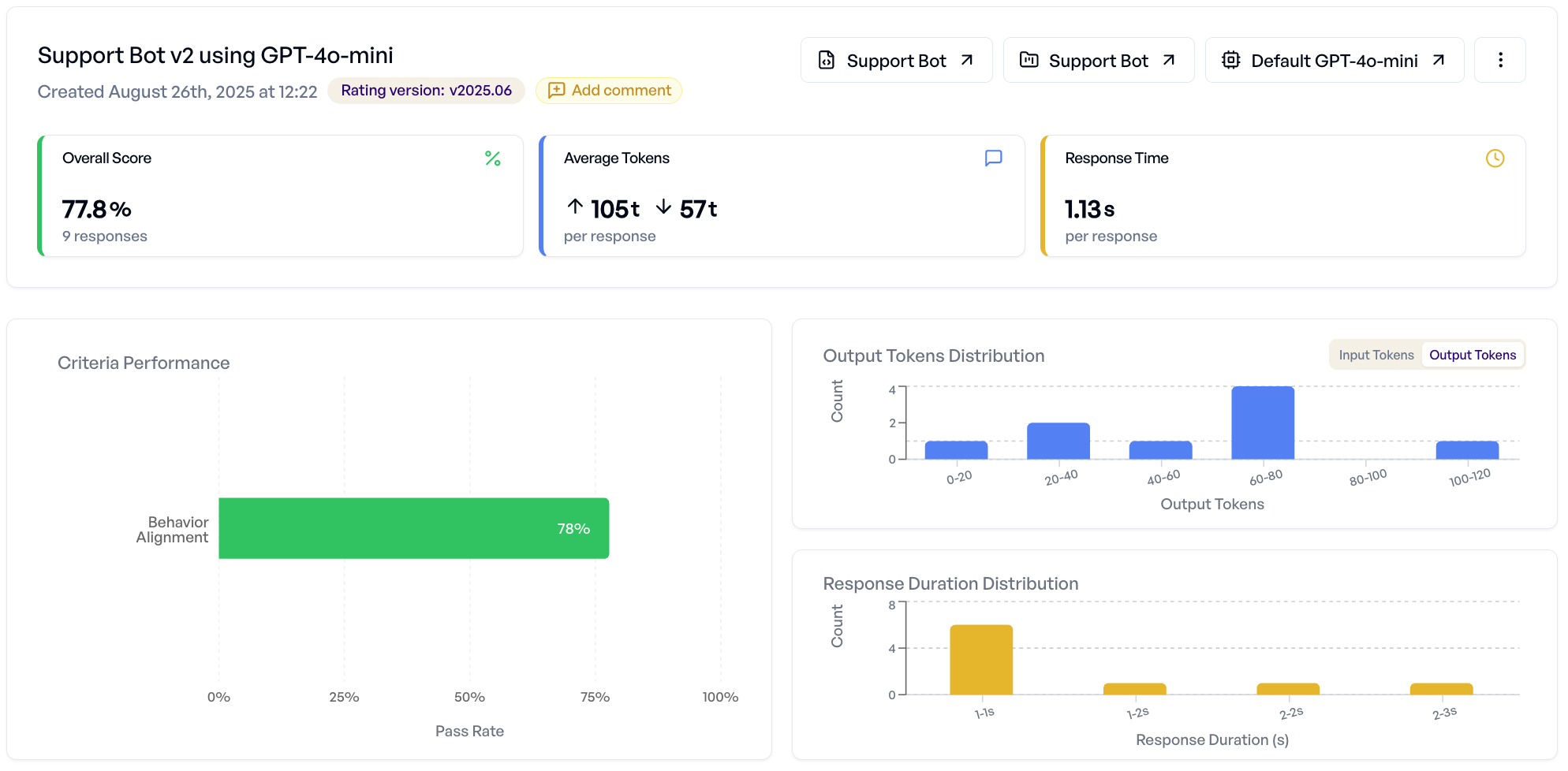

Tab "Detailed Analysis"¶

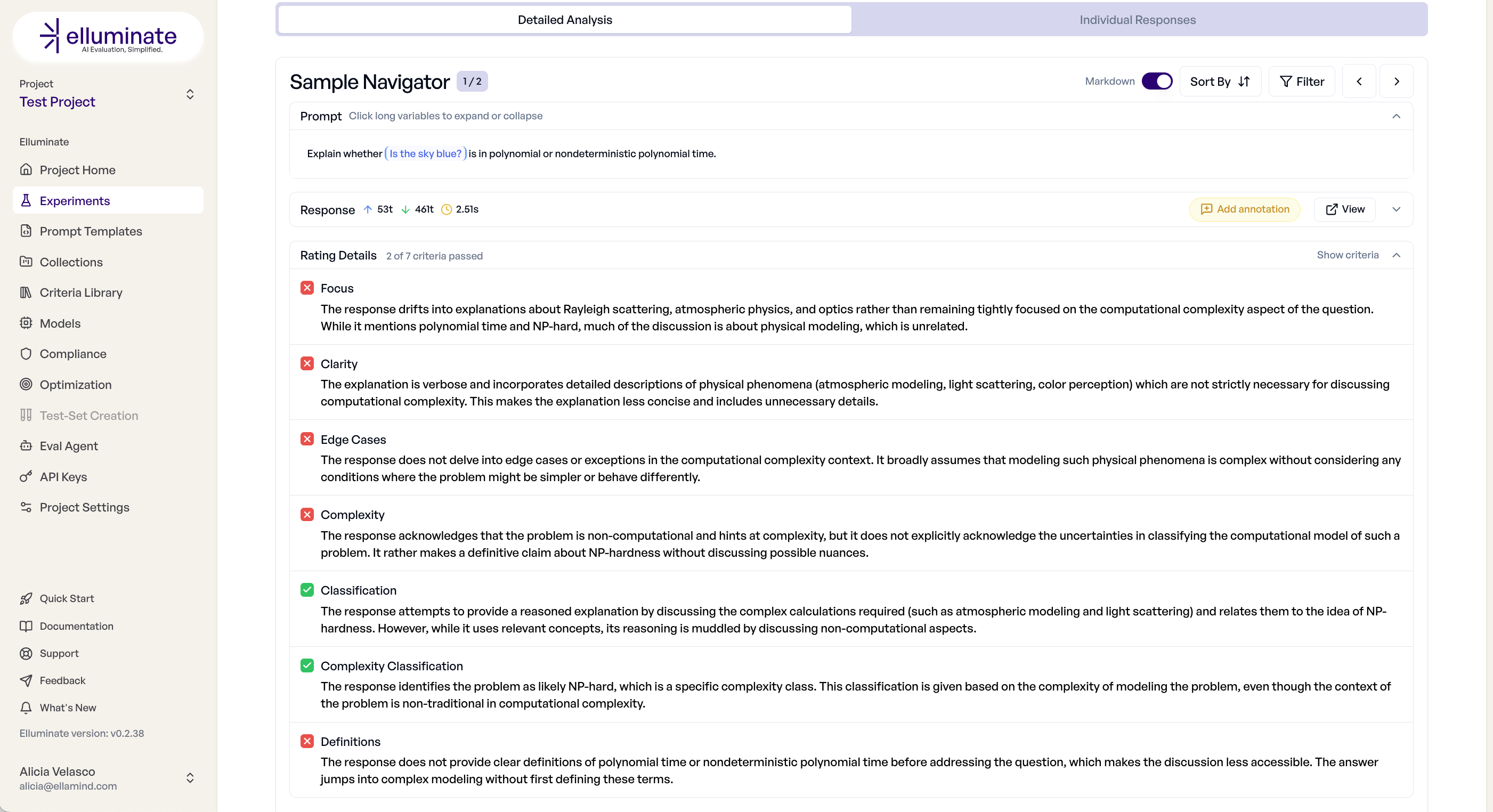

Dieser Tab bietet aggregierte Einblicke und die Inspektion von einzelnen Antworten:

- Overall Score - Erfolgsraten, Score-Verteilungen, Token-Verbrauch

- Criterion Breakdown - Welche Kriterien am häufigsten bestehen/nicht bestehen

- Sample Navigator - Durchsuchen einzelner Antworten mit vollständigen Bewertungsdetails

- Performance-Charts - Visuelle Analyse von Score-Mustern und Verteilungen

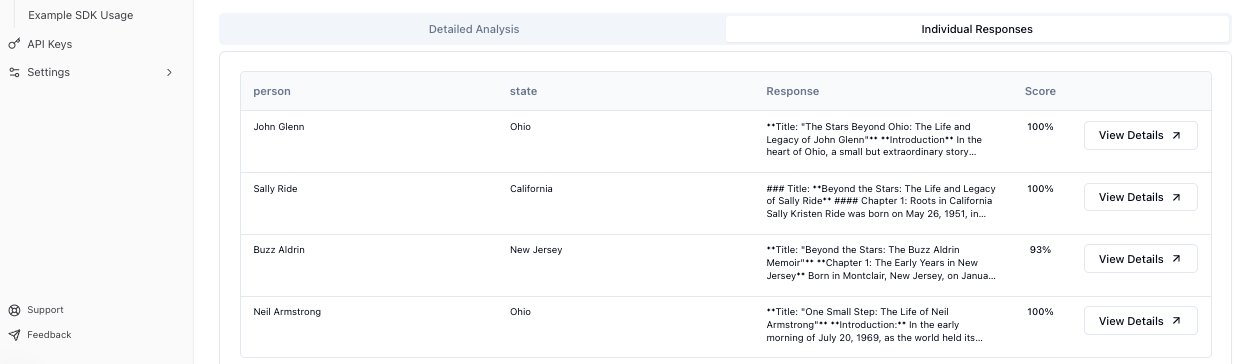

Tab "Individual Responses"¶

Dieser Tab bietet eine tabellarische Ansicht aller Ergebnisse:

- Antwort-Tabelle - Sortierbare Liste aller Prompt-Antwort-Paare

- Bewertungsdetails - Bestanden/Nicht-bestanden-Status für jedes Kriterium pro Antwort

- Export-Optionen - Ergebnisse als CSV mit vollständigen Daten herunterladen

- Filtern - Fokus auf bestimmte Score-Bereiche oder Kriterien-Ergebnisse

Für detaillierte Analysetechniken siehe den Response Analyse Guide.

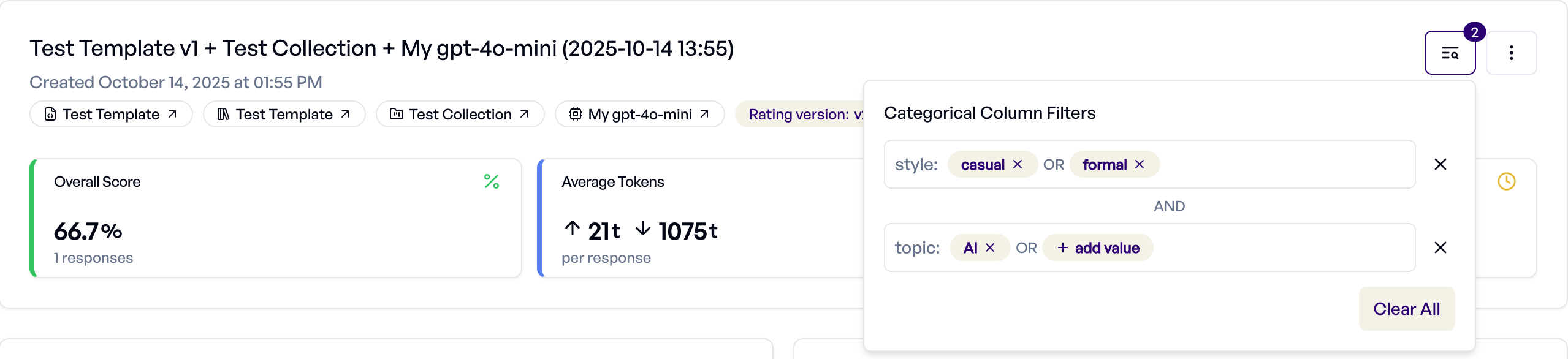

Filtern nach Kategorie-Spalten¶

Wenn Ihre Collection Spalten des Typs Kategorie enthält, können Sie Experiment-Antworten filtern, um die Leistung über verschiedene Kategorien hinweg zu analysieren.

Setup: Konfigurieren Sie Spalten als Kategorie-Typ in Ihrer Collection. Details finden Sie unter Collection-Spalten verwalten.

Verwendung:

- Klicken Sie oben rechts auf das Filter-Symbol

- Wählen Sie Kategorie-Spalten und Werte aus, die einbezogen werden sollen

- Mehrere Werte innerhalb einer Spalte verwenden ODER-Logik (zeigt Antworten, die mit einem beliebigen Wert übereinstimmen)

- Mehrere Spalten verwenden UND-Logik (zeigt Antworten, die alle Bedingungen erfüllen)

- Metriken und Diagramme werden aktualisiert, um nur gefilterte Antworten zu reflektieren

Dies ermöglicht gezielte Analysen - zum Beispiel das Filtern nach user_type als Enterprise oder SMB, um die Leistung über Kundensegmente hinweg zu vergleichen, oder region als US oder EU, um die regionale Effektivität zu analysieren.

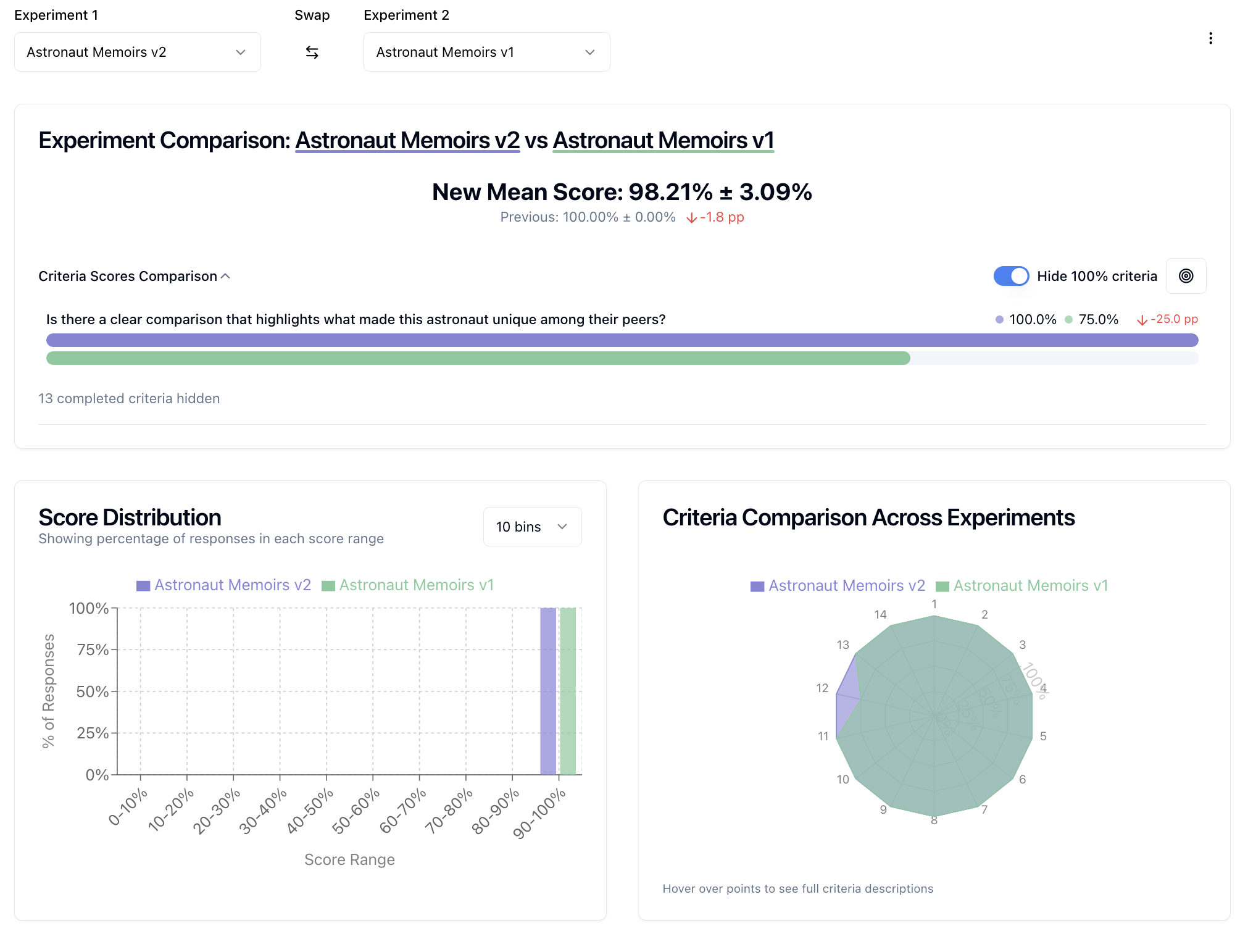

Experimente vergleichen¶

elluminate unterstützt das Vergleichen von Experimenten, um Verbesserungen zu identifizieren und Leistungsänderungen zu verfolgen.

Zwei-Experiment-Vergleich¶

Vergleichen Sie zwei Experimente nebeneinander, um Unterschiede zu verstehen:

- Wählen Sie zwei Experimente aus Ihrer Liste

- Klicken Sie auf "Compare" für eine detaillierte Vergleichsansicht

- Analysieren Sie nebeneinander Antworten, Kriterien-Performance-Deltas und Gesamtscore-Änderungen

Multi-Experiment-Vergleich¶

Für einen Überblick über mehrere Experimente hinweg:

- Wählen Sie 3+ Experimente aus Ihrer Liste

- Nutzen Sie die Multi-Vergleichsansicht für aggregierte Performance-Trends

- Identifizieren Sie, welche Experimente bei verschiedenen Kriterien am besten abschneiden

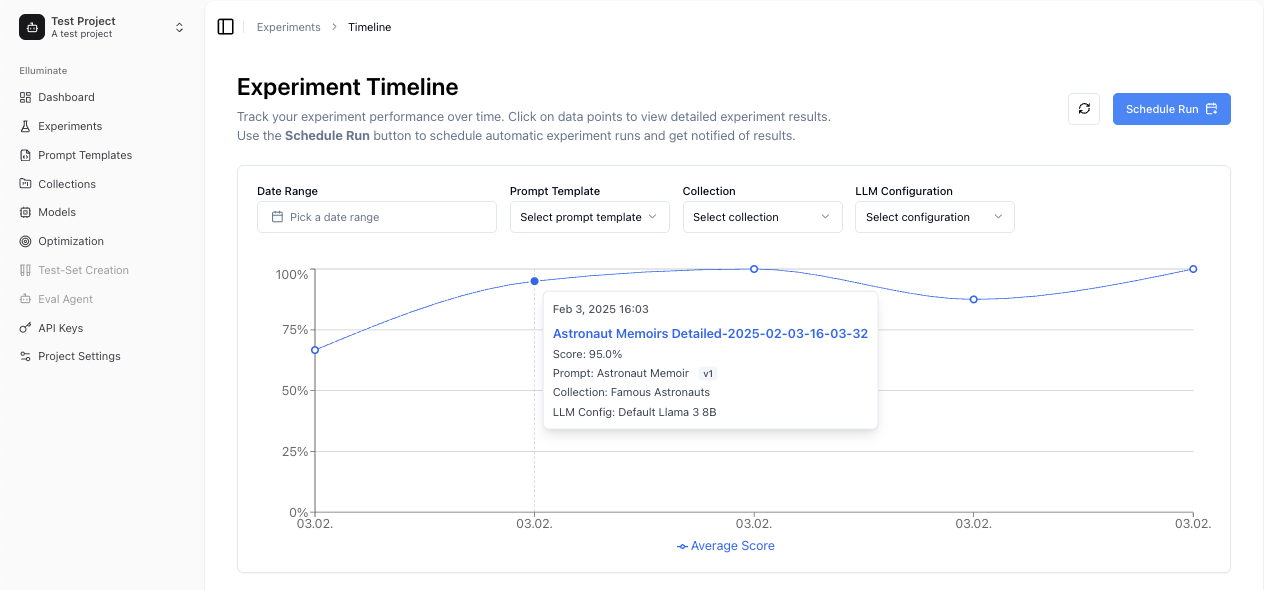

Performance über Zeit überwachen¶

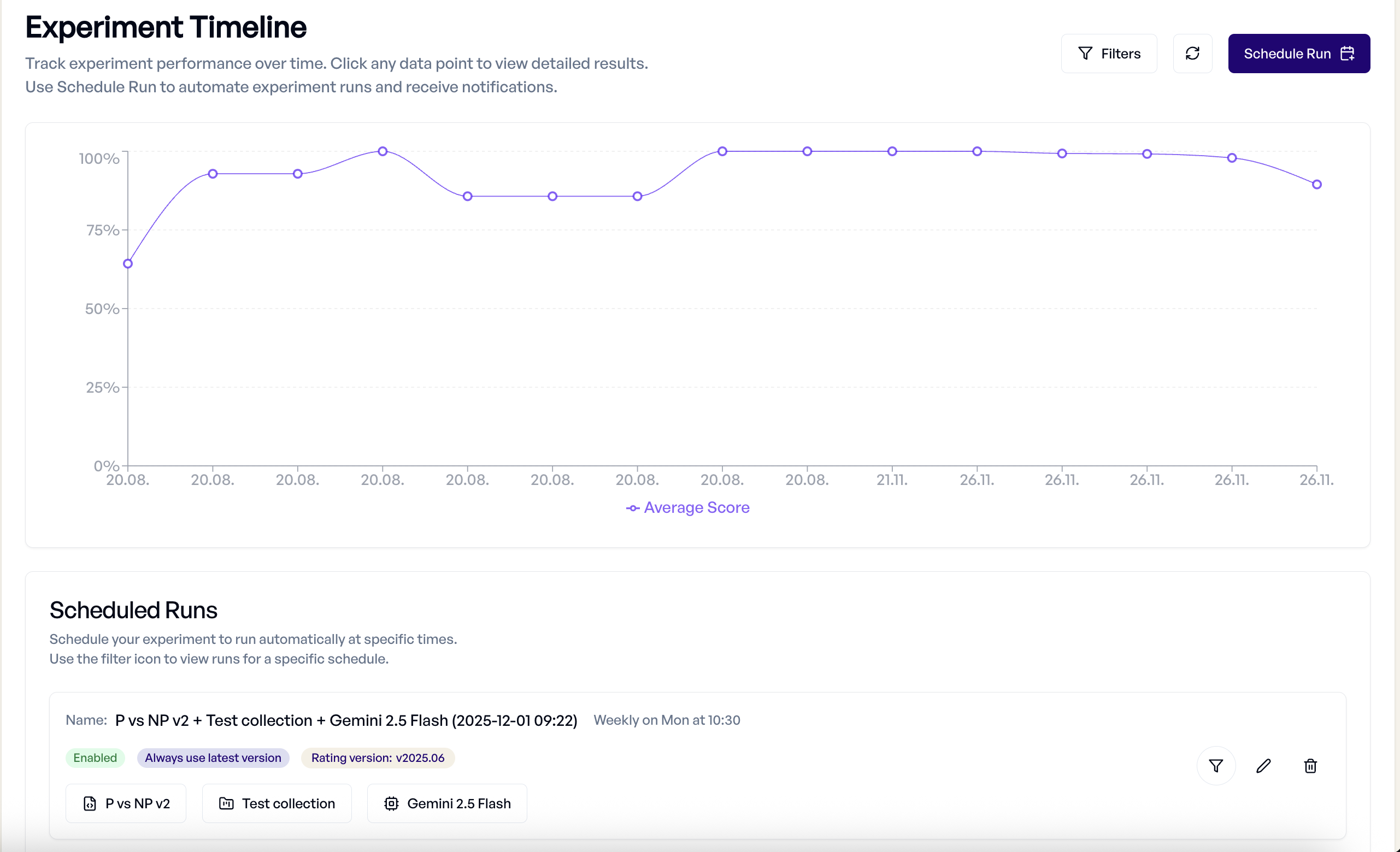

Timeline-Ansicht¶

Die Timeline bietet historische Performance-Verfolgung:

- Performance-Trends - Sehen Sie, wie Ihre Experimente über die Zeit abschneiden

- Filter-Optionen - Filtern Sie nach Zeitbereich, Prompt Template, Collection oder Modell

- Datenpunkt-Details - Darüberfahren für Experiment-Informationen, klicken für Detailansicht

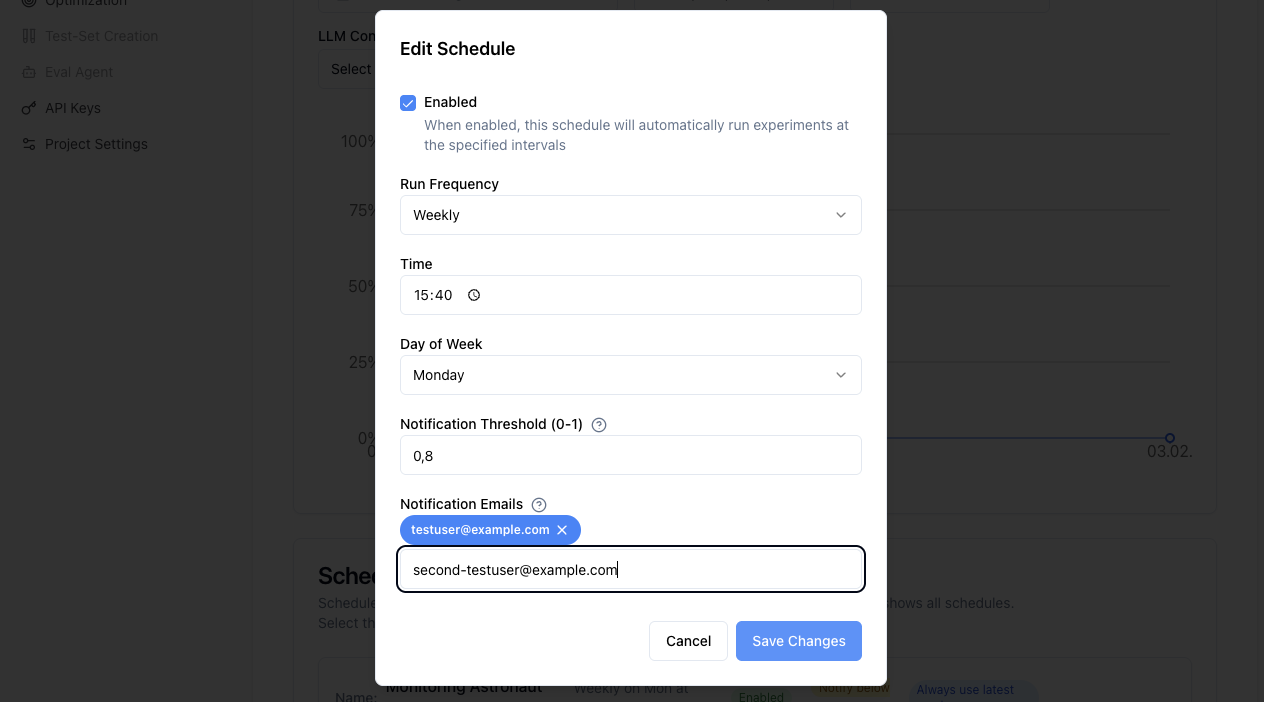

Geplante Experimente¶

Es ist möglich, regelmäßige Evaluierungen mit geplanten Experimenten zu automatisieren.

Zeitpläne erstellen:

- Klicken Sie in der Timeline-Ansicht auf "Schedule Run"

- Konfigurieren Sie Häufigkeit (täglich, wöchentlich, monatlich)

- Setzen Sie Experiment-Parameter (Template, Collection, Modell)

- Konfigurieren Sie Benachrichtigungen und Schwellenwerte

Zeitplan-Management:

Um Ihre Zeitpläne zu verwalten, navigieren Sie zur Timeline-Ansicht und scrollen Sie nach unten. Dort können Sie:

- Alle Zeitpläne anzeigen - Überwachen Sie aktive Zeitpläne und ihre Einstellungen mithilfe der Filterfunktion

- Zeitpläne bearbeiten - Häufigkeit und Schwellenwerte modifizieren oder Zeitpläne deaktivieren

- Zeitpläne löschen - Zeitpläne löschen, ohne die vorherigen Experimente zu verändern

Fortgeschrittene Features¶

Structured Outputs und Tool Calling¶

Experimente funktionieren nahtlos mit fortgeschrittenen LLM-Features:

- Structured Outputs - JSON-Antworten mit Schema-Validierungskriterien evaluieren

- Tool Calling - Tool-Nutzung und Parameter-Korrektheit in agentischen Anwendungen bewerten

- Multi-Step-Workflows - Komplexe Interaktionsmuster evaluieren

Für Details siehe Structured Outputs und Tool Calling.

Integration mit anderen Komponenten¶

Experimente nutzen Ihr gesamtes elluminate-Setup:

- Collections - Testdatensätze über verschiedene Experimente wiederverwenden

- Prompt Templates - Versionskontrolle gewährleistet Experiment-Reproduzierbarkeit

- Criterion Sets - Konsistente Evaluationsstandards anwenden

- LLM Configs - Verschiedene Modelle und Parameter systematisch testen

Best Practices¶

Experiment-Design¶

- Klare Ziele - Definieren Sie, was Sie testen, bevor Sie Experimente ausführen

- Repräsentative Daten - Stellen Sie sicher, dass Ihre Collection reale Szenarien abdeckt

- Geeignete Kriterien - Wählen Sie Evaluationskriterien, die zu Ihrem Anwendungsfall passen

- Kontrollierte Variablen - Ändern Sie jeweils nur eine Sache für klare Erkenntnisse

Performance-Optimierung¶

- Batch-Testing - Führen Sie mehrere Variationen zusammen für schnellere Iteration aus

- Strategisches Sampling - Nutzen Sie kleinere Collections für schnelles Prototyping

- Kostenmanagement - Nutzen Sie den Fast-Rating-Modus, wenn detaillierte Erklärungen nicht benötigt werden

- Historischer Kontext - Vergleichen Sie mit vorherigen Experimenten, um Verbesserungen zu verfolgen

Qualitätssicherung¶

- Manuelle Überprüfung - Stichproben der automatisierten Bewertungen auf Genauigkeit prüfen

- Edge-Case-Testing - Herausfordernde Szenarien in Ihre Collections einschließen

- Konsistente Evaluation - Gleiche Criterion Sets für vergleichbare Ergebnisse verwenden

- Dokumentation - Experimentziele und Erkenntnisse in Beschreibungen festhalten

SDK-Integration¶

Für programmatische Experiment-Erstellung und -Management können Sie das elluminate SDK verwenden:

from elluminate import Client

from elluminate.schemas import RatingMode

client = Client() # Nutzt ELLUMINATE_API_KEY env var

Für vollständige SDK-Dokumentation siehe die API-Referenz.

Troubleshooting¶

Häufige Probleme¶

- Generierungsfehler - LLM-Config-Einstellungen und Rate-Limits überprüfen

- Bewertungsfehler - Criterion Set-Kompatibilität mit Antwortformat verifizieren

- Performance-Probleme - Fast-Rating-Modus für große Collections verwenden

- Fehlende Ergebnisse - Vor der Analyse sicherstellen, dass das Experiment erfolgreich abgeschlossen wurde

Hilfe erhalten¶

Wenn Experimente nicht wie erwartet funktionieren:

- Logs überprüfen - Experiment-Logs auf spezifische Fehlermeldungen überprüfen

- Komponenten validieren - Prompt Templates und Collections unabhängig testen

- Einstellungen überprüfen - Prüfen, ob LLM-Config-Parameter geeignet sind

- Support kontaktieren - Mit Experiment-IDs für detaillierte Unterstützung