Structured Outputs¶

Beherrschen Sie die Evaluierung von programmatisch formatierten LLM-Antworten, die für agentische Anwendungen essentiell sind

Structured Outputs ermöglichen Entwicklern, sicherzustellen, dass das LLM Antworten in einem programmatisch deterministischen Format erzeugt. Agentische Programme nutzen diese Funktion intensiv, um Interoperabilität zwischen Code-Pfaden und LLM-Antworten zu ermöglichen. Dies macht die Evaluierung structured Outputs zu einem wesentlichen Bestandteil der Evaluierung von Agenten.

Grundlegende Verwendung¶

Ein Beispiel, das die Verwendung von Pydantic-Modellen für die Generierung und Evaluierung von structured Outputs zeigt:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 | |

-

Schema definieren: Erstellen Sie ein Pydantic-Modell mit Feldbeschreibungen und grundlegenden Constraints, um die exakte JSON-Struktur zu definieren, die das LLM zurückgeben soll

-

Template erstellen: Verwenden Sie den Parameter

response_formatbeim Erstellen eines Prompt-Templates, um anzugeben, dass Antworten Ihrer Pydantic-Modellstruktur folgen sollen -

Kriterien hinzufügen: Definieren Sie Evaluierungskriterien, die sich auf spezifische Schema-Felder beziehen - Kriterien können auch wie gewohnt automatisch generiert werden

-

Experiment ausführen: Erstellen und führen Sie Experimente normal aus - das strukturierte Ausgabeformat wird automatisch für alle Antwortgenerierungen angewendet

-

Auf Antworten zugreifen: Die structured Outputs finden sich im

content-Feld der Assistant-Nachricht als JSON-String

Schema-Definitionsmethoden¶

Pydantic-Modelle¶

Pydantic-Modelle bieten die intuitivste und empfohlene Art, Schemas für structured Outputs zu definieren. Setzen Sie einfach response_format auf die Pydantic-Klassendefinition, und elluminate übernimmt den Rest.

OpenAI JSON Schema Format¶

Zusätzlich zu Pydantic-Modellen können Sie auch das response_format direkt mit einer OpenAI JSON Schema-Definition setzen:

schema = {

"type": "json_schema",

"json_schema": {

"name": "sentiment",

"schema": {

"type": "object",

"properties": {

"stars": {

"type": "integer",

"description": "Anzahl der Sterne der Bewertung",

"minimum": 1,

"maximum": 5

},

"sentiment": {

"type": "string",

"description": "Die Stimmungsausgabe, könnte positiv, negativ oder neutral sein.",

"enum": [

"positive",

"negative",

"neutral"

]

},

"confidence": {

"type": "number",

"description": "Konfidenzwert der Stimmungsanalyse zwischen 0 und 1",

"minimum": 0,

"maximum": 1

}

},

"required": [

"stars",

"sentiment",

"confidence"

],

"additionalProperties": False

}

}

}

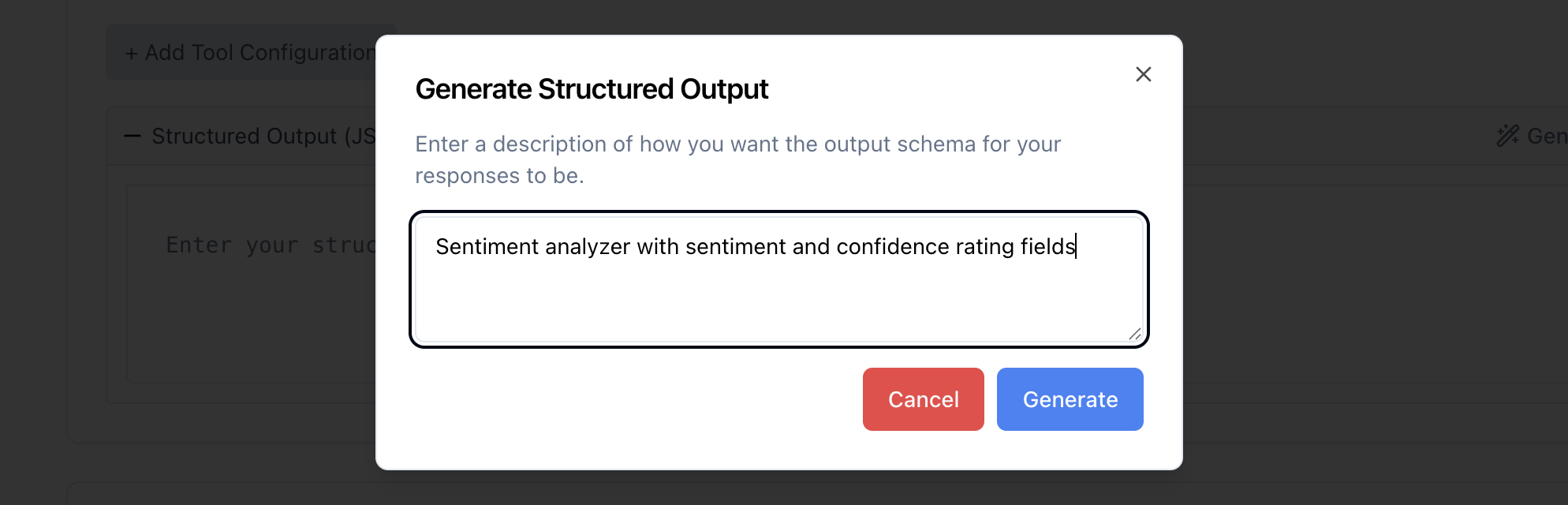

KI-gestützte Schema-Generierung¶

Das Frontend bietet einen KI-gestützten Schema-Generator, der JSON-Schemas aus natürlichsprachlichen Beschreibungen erstellt. Beschreiben Sie einfach, was Sie extrahieren möchten, und elluminate generiert ein entsprechendes Schema.

Evaluierung von structured Outputs¶

Das Rating-Modell hat Zugriff auf alle Feldbeschreibungen aus Ihrem Schema für structured Outputs und bietet dadurch wertvollen Kontext darüber, was jedes Feld enthalten sollte und wie es interpretiert werden sollte. Um structured Outputs zu evaluieren, erstellen Sie einfach wie gewohnt Kriterien und führen ein Experiment aus.

Verwendung von Feldnamen in Kriterien

Es kann vorteilhaft sein, Feldnamen aus Ihrem Schema in den Kriterien zu verwenden. Dies hilft dem Rating-Modell zu verstehen, auf welchen Teil der JSON-Struktur es sich genau konzentrieren soll. Zum Beispiel ist "Ist das 'sentiment'-Feld..." präziser als "Ist die Stimmung korrekt?"