Grundlagen¶

Beherrschen Sie die Kernkomponenten von elluminate und wie sie zusammenarbeiten, um eine systematische Bewertung von KI-Systemen zu ermöglichen

Dieser Abschnitt führt die Kernkomponenten von elluminate ein und wie sie zusammenarbeiten, um eine systematische Bewertung von KI-Systemen zu ermöglichen. Wenn Sie das in Aktion sehen möchten, schauen Sie sich unseren Schnellstart an oder erkunden Sie unsere detaillierten Konzeptleitfäden unten.

Projekte und Templates¶

Im Herzen von elluminate stehen die Konzepte von Projects, PromptTemplates, TemplateVariables und die daraus resultierenden Prompts.

- Projects dienen als übergeordneter Container für die Organisation all Ihrer Bewertungsarbeit. Projekte können innerhalb Ihrer Organisation privat (nur Projektmitglieder haben Zugriff) oder öffentlich sein.

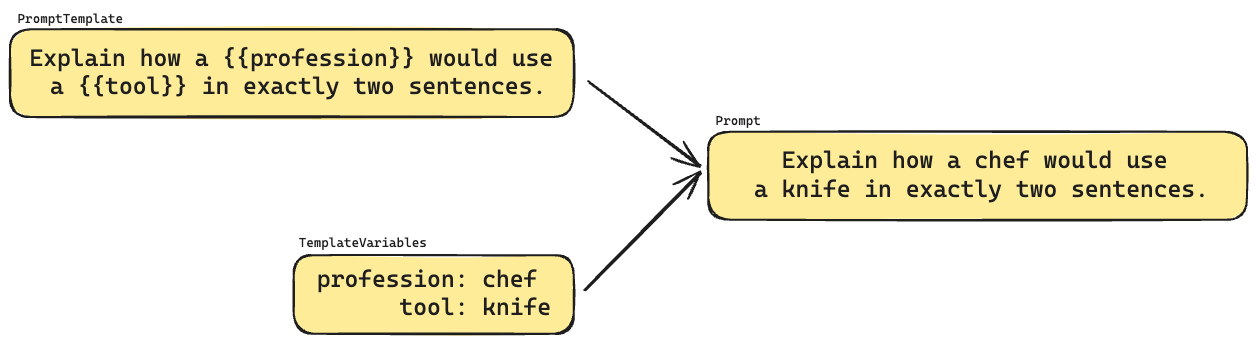

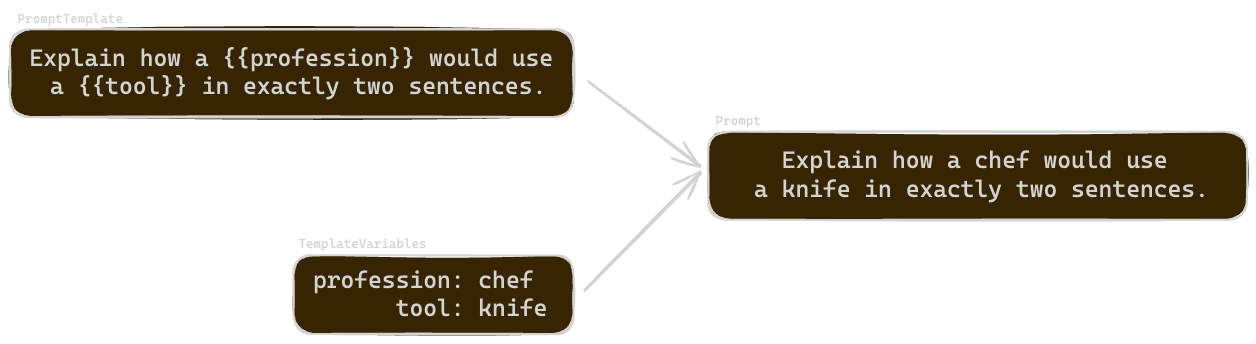

- Prompt templates sind wiederverwendbare Vorlagen mit Variablen, die durch spezifische Werte ersetzt werden können

- Template variables sind Key-Value-Paare, die in einem Prompt-Template eingefügt werden können

- Prompts sind das Ergebnis der Kombination eines Prompt-Templates mit Template-Variablen

Collections¶

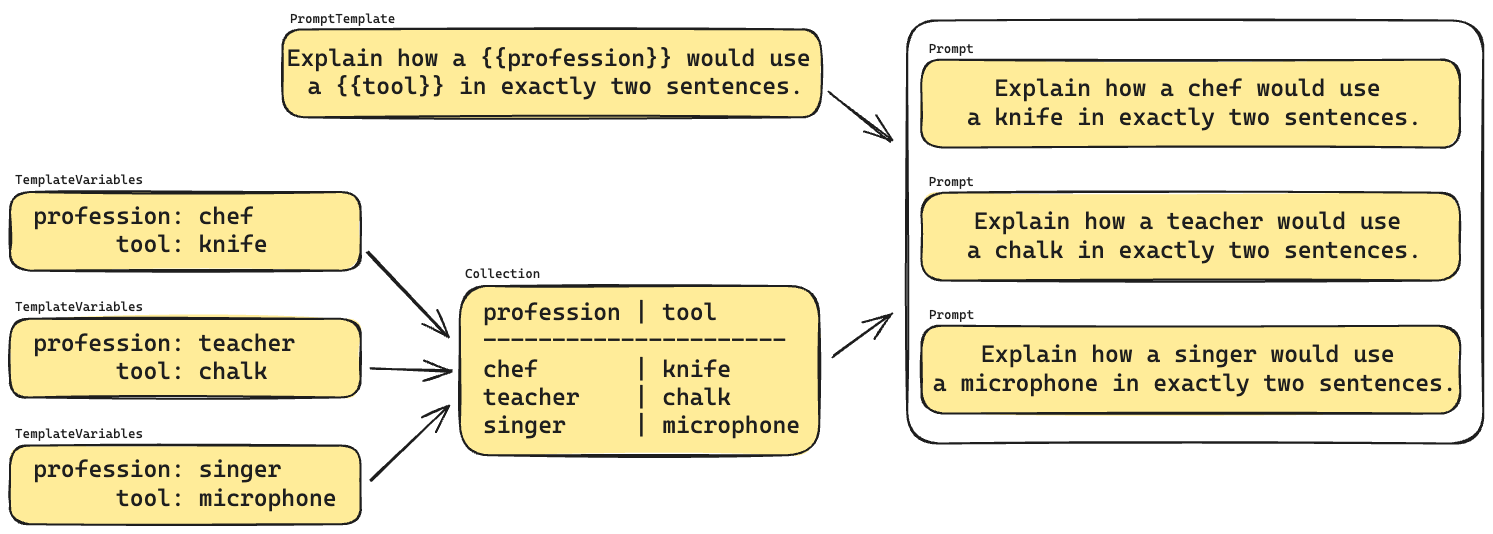

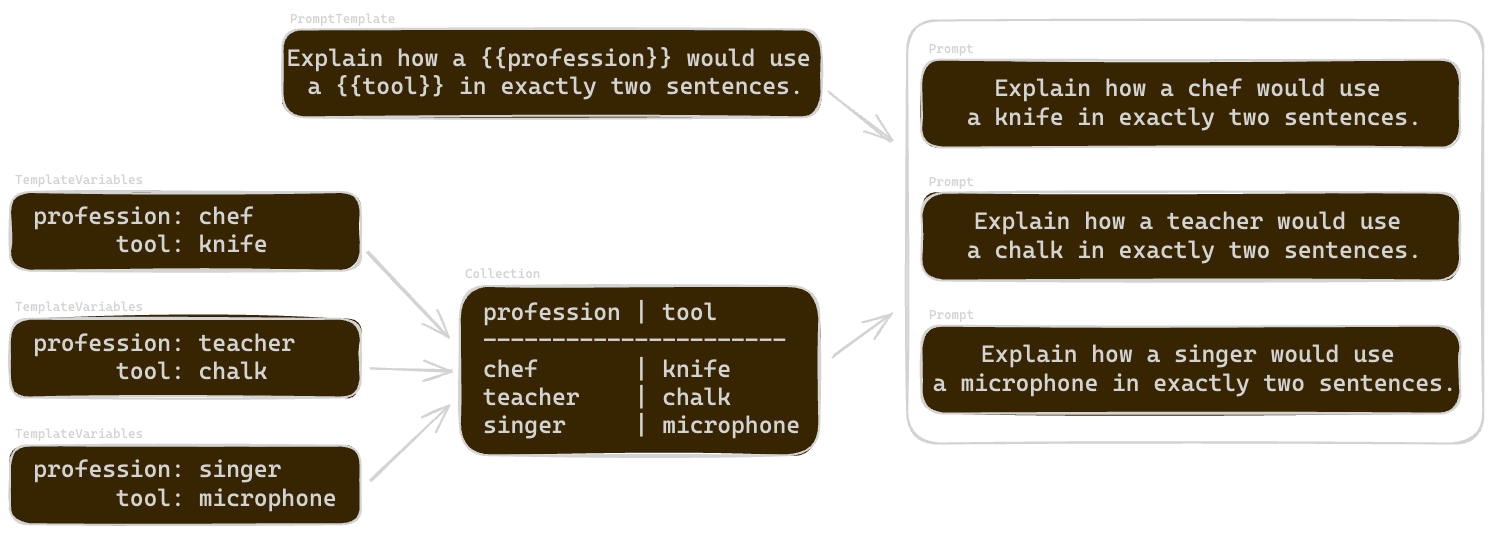

Template-Variablen können in einer Collection (speziell einer TemplateVariablesCollection) gruppiert werden. Dies organisiert verwandte Sets von Template-Variablen und ermöglicht es Ihnen, mehrere Prompts systematisch zu generieren.

Collections helfen Ihnen:

- Verwandte Sets von Variablen zu organisieren

- Mehrere Prompts aus einer einzigen Vorlage zu generieren

- Konsistente Testfälle zu verwalten

- Bewertung über diverse Szenarien zu skalieren

Bewertung und Analyse¶

Prompts generieren Antworten, typischerweise von LLMs. elluminate ermöglicht es Ihnen, diese Antworten systematisch mit Criterion Sets zu bewerten und die Ergebnisse durch Response Analyse zu analysieren.

Criterion Sets und Criteria¶

- Criterion Sets gruppieren verwandte Bewertungsfragen

- Criteria sind spezifische binäre Fragen, die Antwortqualität bewerten

- Jedes Kriterium erhält eine "Ja"- oder "Nein"-Bewertung mit detaillierter Begründung

Experimente¶

Experimente bringen alles zusammen, indem sie kombinieren:

- Ein spezifisches Prompt-Template

- Eine Collection von Test-Variablen

- LLM-Konfigurationseinstellungen

- Criterion Sets für die Bewertung

Response Analyse¶

Sobald Antworten generiert und bewertet wurden, bietet Response Analyse Tools, um:

- Einzelne Antwortbewertungen zu überprüfen

- Muster über mehrere Antworten zu identifizieren

- Performance über verschiedene Konfigurationen zu vergleichen

- Datengetriebene Verbesserungen an Ihrem AI-System vorzunehmen

Versionskontrolle¶

Versionierung gewährleistet Bewertungskonsistenz und ermöglicht Änderungsverfolgung:

- Alle Komponenten (Templates, Collections, Criterion Sets) sind versioniert

- Experimente referenzieren spezifische Versionen für Reproduzierbarkeit

- Änderungen erstellen neue Versionen, während historische Daten erhalten bleiben

Nächste Schritte¶

Jetzt, da Sie die grundlegenden Konzepte verstehen, können Sie:

- Jedes Konzept im Detail mit den Leitfäden in diesem Abschnitt erkunden

- Unserem Schnellstart folgen, um diese Konzepte in Aktion zu sehen

- Die SDK-Beispiele für programmatischen Zugriff ausprobieren