Quick Start (GUI)¶

Beginnen Sie in nur wenigen Minuten mit der Bewertung von Prompts mit elluminate über die Web-Oberfläche

Keine Programmierkenntnisse erforderlich! Für einen code-basierten Ansatz siehe unsere SDK Quick Start.

Voraussetzungen¶

Sie benötigen:

- Ein elluminate Benutzerkonto

Schritt 1: Anmelden und Zugriff auf Ihr Projekt¶

Navigieren Sie zu app.elluminate.de oder Ihrer benutzerdefinierten Instanz und melden Sie sich mit Ihren Anmeldedaten an.

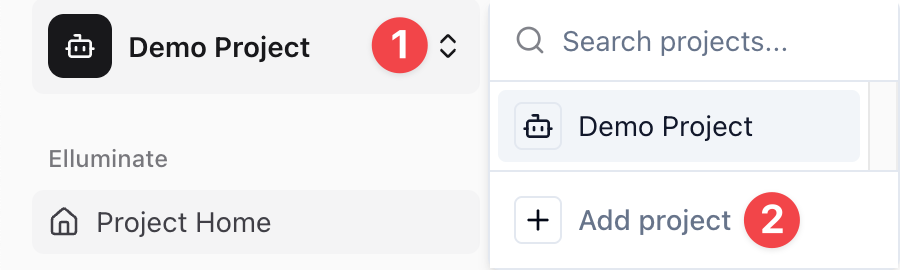

Schritt 2: Ein neues Testprojekt erstellen¶

Für dieses Tutorial erstellen wir ein neues Projekt zum Experimentieren. Dies hält Ihre Testdaten von bestehenden Arbeiten getrennt.

1. Klicken Sie auf den Projektnamen in der oberen linken Ecke (z.B. My First Project)

2. Klicken Sie im Dropdown-Menü auf Add project

3. Füllen Sie den Project Name aus: "Test Project" (oder einen beliebigen Namen Ihrer Wahl)

4. Optional füllen Sie die Description aus: "A test project"

5. Klicken Sie auf Create Project

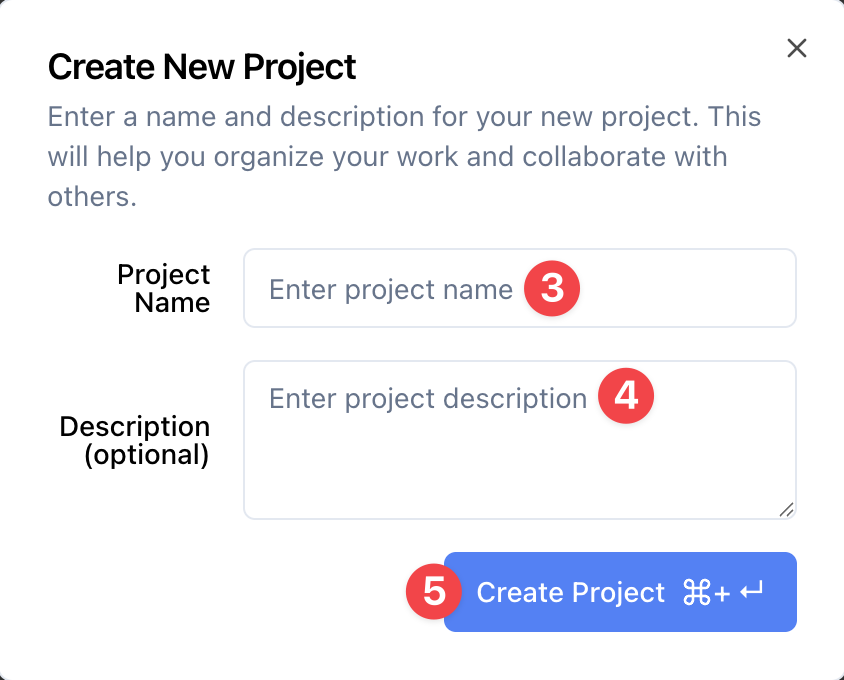

6. Sie sehen jetzt Ihr neues Projekt mit der leeren Prompt Templates Seite

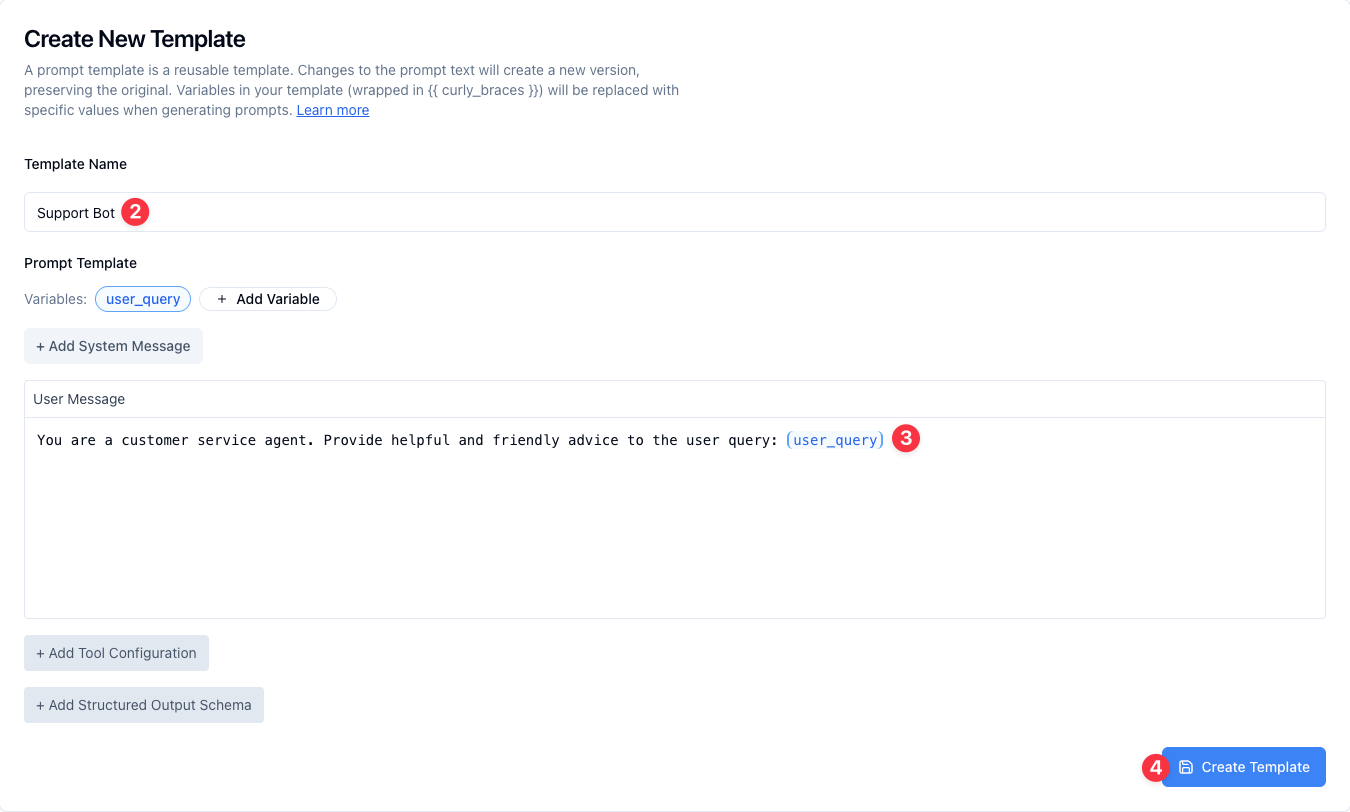

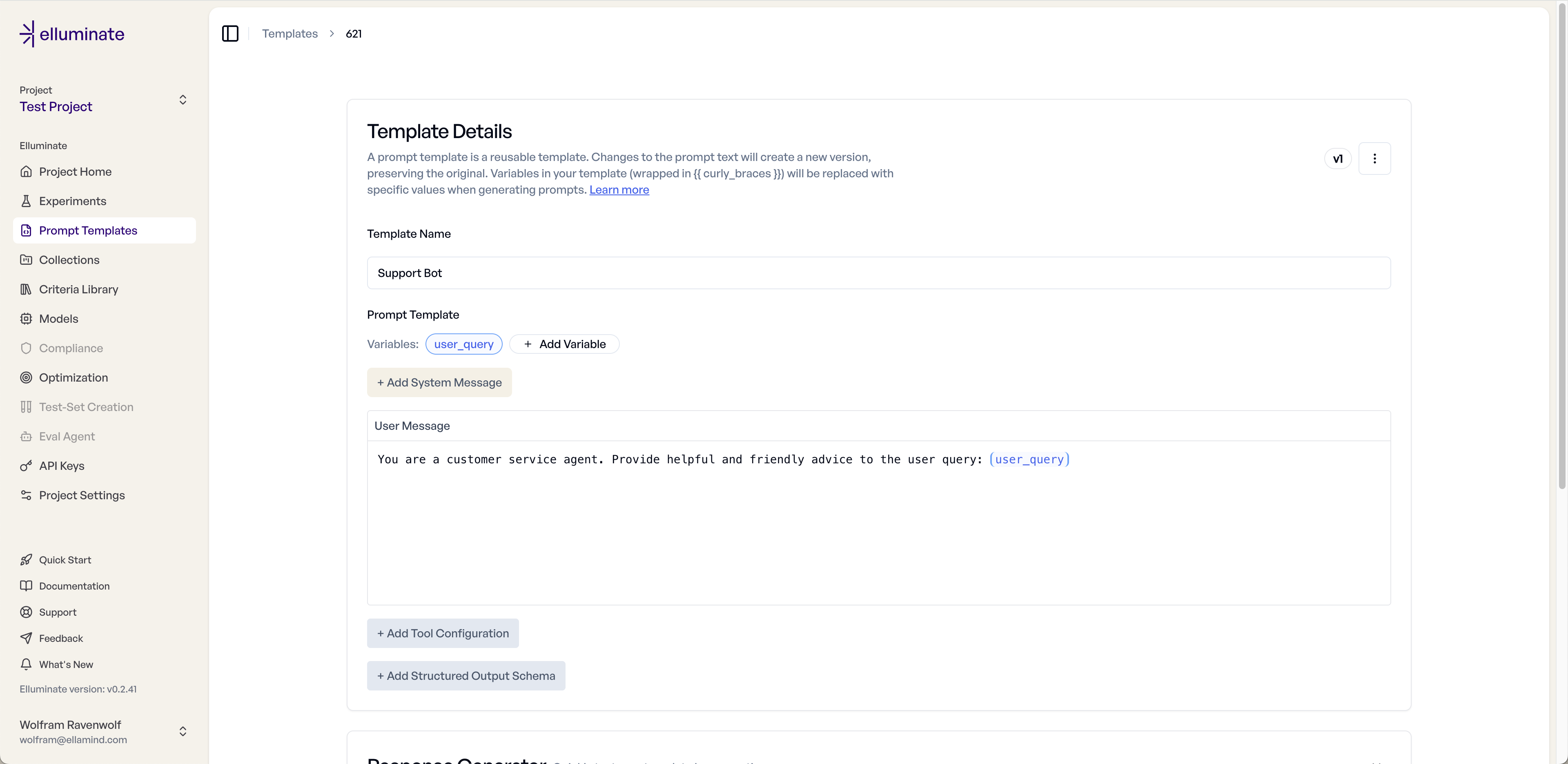

Schritt 3: Ein Prompt Template erstellen¶

Erstellen Sie Ihr erstes Prompt Template. Sie sollten bereits auf der Prompt Templates Seite vom vorherigen Schritt sein, aber falls nicht, klicken Sie auf Prompt Templates in der Seitenleiste.

1. Klicken Sie auf den New Template Button in der oberen rechten Ecke

2. Geben Sie den Template Name ein: "Support Bot"

3. Geben Sie die User Message ein: "You are a customer service agent. Provide helpful and friendly advice to the user query: {{user_query}}"

4. Klicken Sie auf Create Template um Ihr Template zu erstellen

5. Sie sehen jetzt die Templates Details Seite

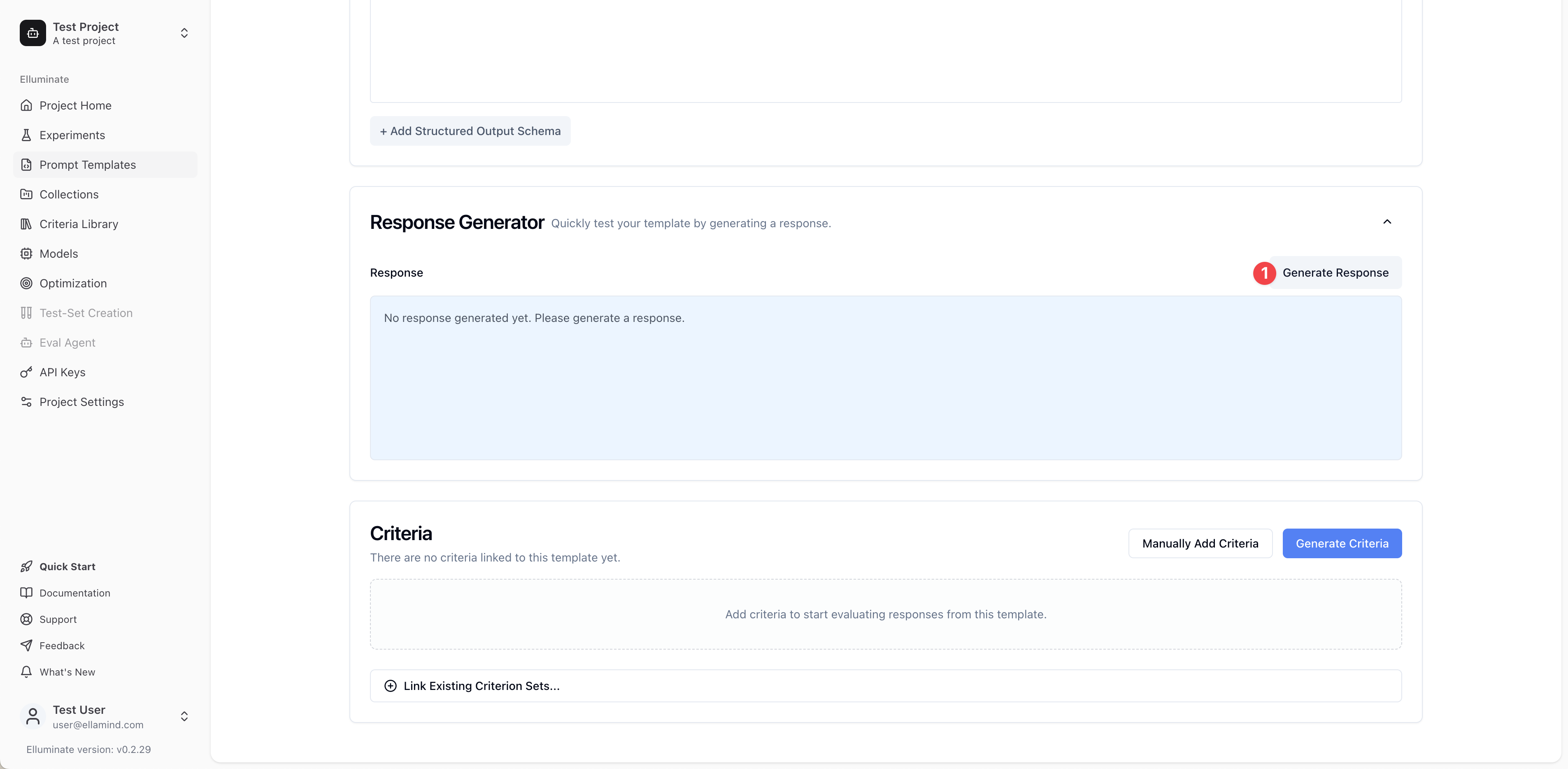

Schritt 4: Ihr Template testen¶

Bevor wir Bewertungskriterien erstellen, testen wir schnell unser Template mit dem Response Generator am unteren Rand der Template Details Seite.

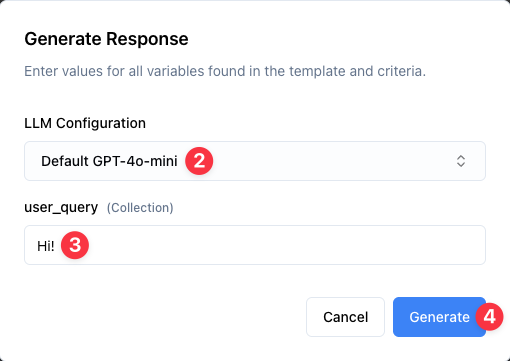

1. Scrollen Sie nach unten zum Response Generator Abschnitt am unteren Rand der Template Details Seite, klicken Sie um den Abschnitt zu erweitern (er ist standardmäßig eingeklappt), dann klicken Sie auf Generate Response um das Response Generation Formular zu öffnen

2. Wählen Sie eine LLM Configuration aus dem Dropdown-Menü (z.B. "Default GPT-5")

3. Geben Sie einen Testwert für die user_query Variable ein; ein einfache Begrüßung ist ein guter Anfang: "Hi!"

4. Klicken Sie auf Generate um zu sehen, wie Ihr Template funktioniert

5. Überprüfen Sie die generierte Response um sicherzustellen, dass Ihr Template wie erwartet funktioniert

Hinweis: Der Response Generator ermöglicht es Ihnen, Ihr Template schnell mit verschiedenen Variablenwerten zu testen, um sicherzustellen, dass es wie erwartet funktioniert, bevor Sie eine systematische Bewertung einrichten.

Schritt 5: Bewertungskriterien hinzufügen¶

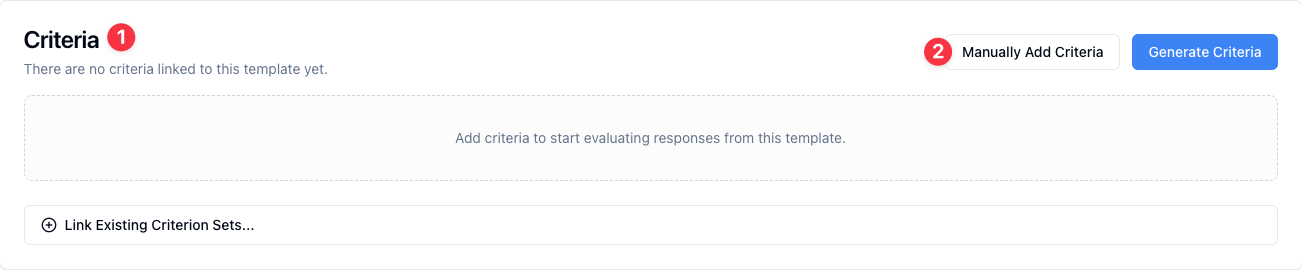

Der Criteria Abschnitt bietet drei Möglichkeiten, Bewertungskriterien zu Ihrem Template hinzuzufügen:

- Create New Criterion Set: Vollständige Kontrolle, wenn Sie spezifische Bewertungsanforderungen benötigen

- Generate Criteria: Sofort loslegen mit KI-generierten Kriterien, die auf Ihren spezifischen Prompt zugeschnitten sind

- Link Existing Criterion Set: Sparen Sie Zeit, indem Sie ein Criterion Set aus Ihrem Projekt wiederverwenden

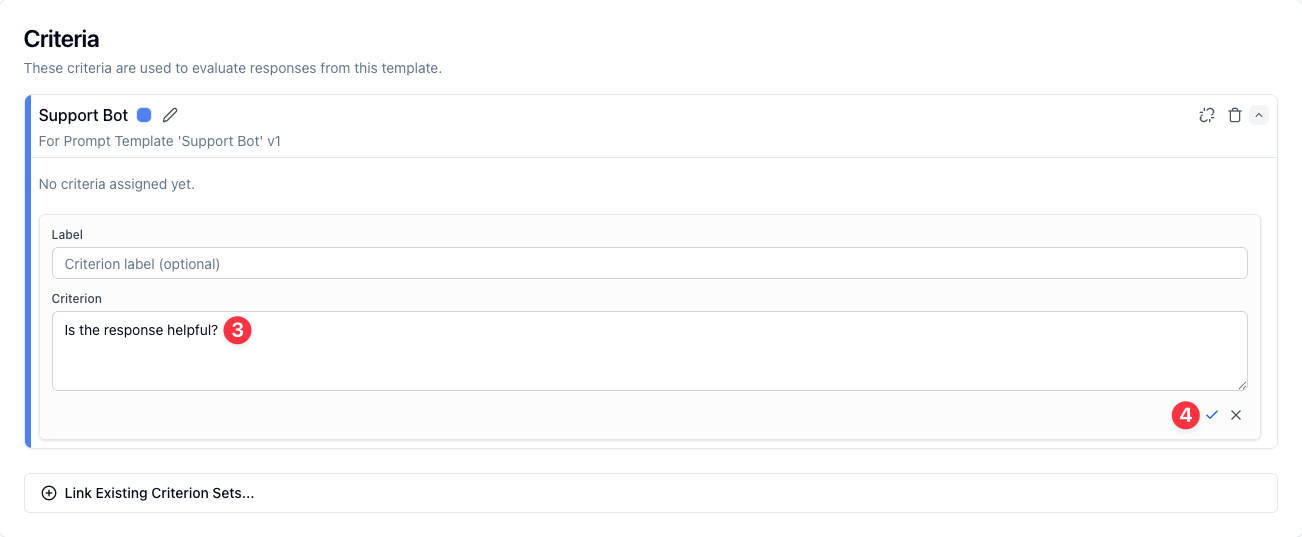

1. In Ihrer Prompt Templates Ansicht finden Sie den Criterion Set Abschnitt unterhalb des Response Generator. Klicken Sie dort auf Create New Criterion Set um Ihre eigenen Bewertungskriterien einzugeben

2. Geben Sie ein Kriterium zur Bewertung von Responses ein, wie z.B.: "Is the response helpful?"

3. Klicken Sie auf das Häkchen um Ihr Kriterium zu speichern

Schritt 6: Eine Template Variables Collection erstellen¶

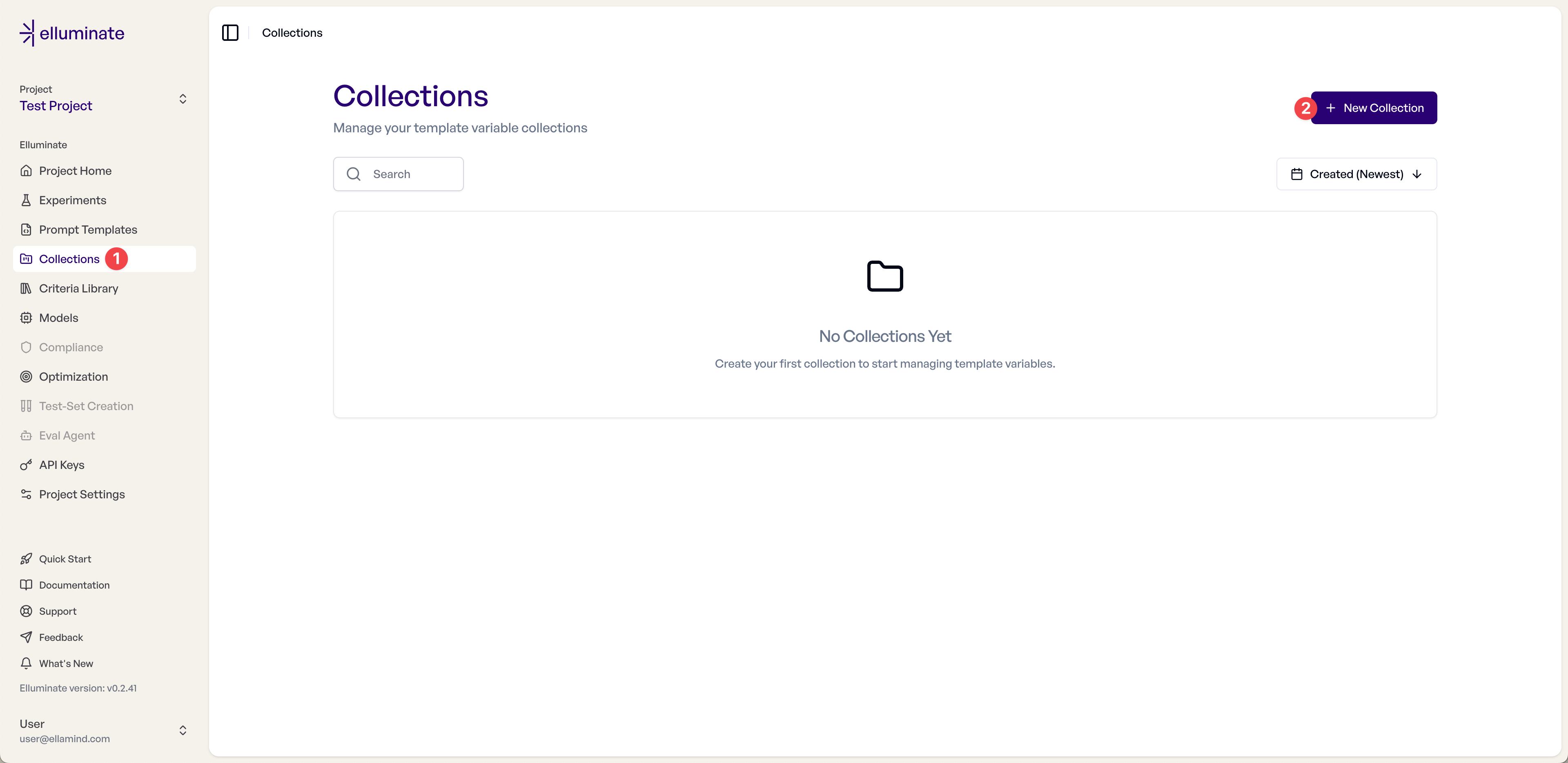

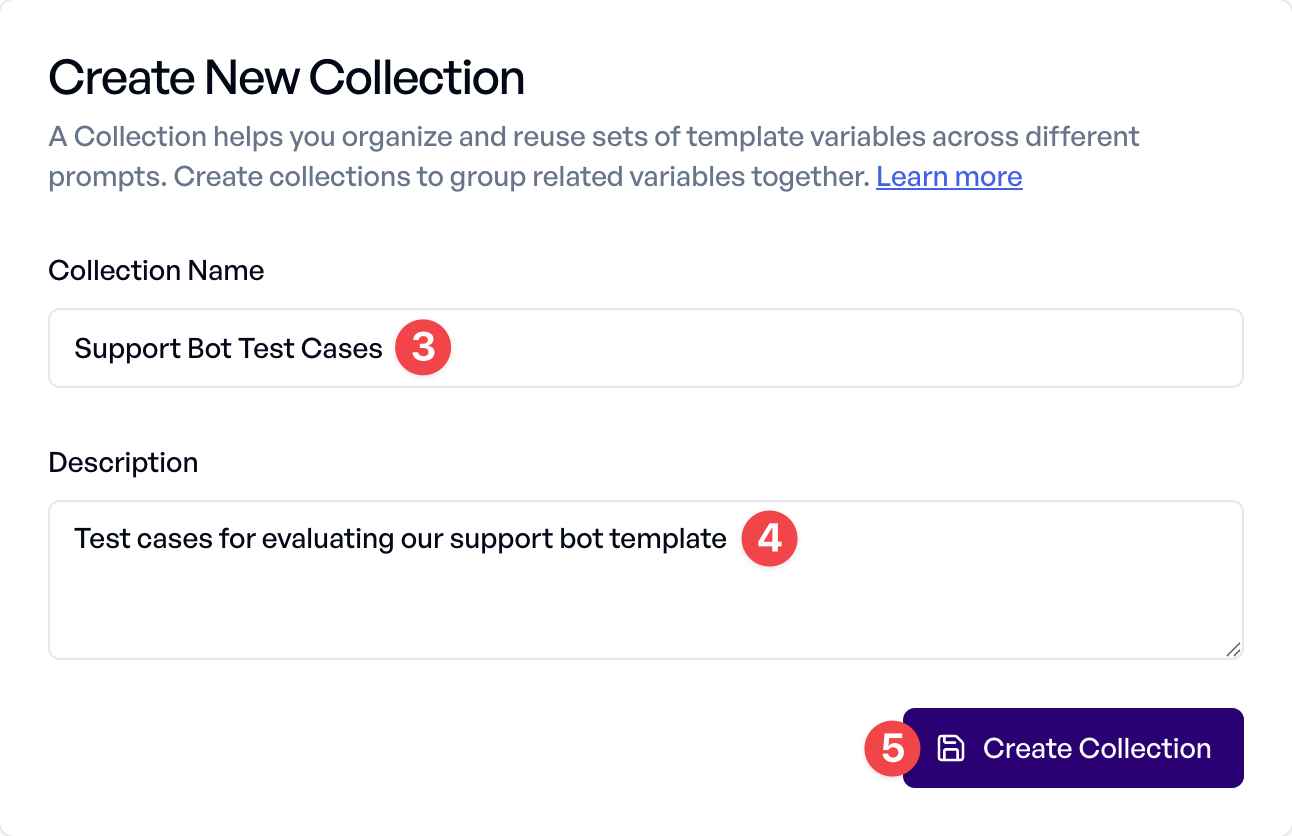

Jetzt müssen wir eine Collection erstellen, um Testfälle für die systematische Bewertung unseres Prompt Templates zu speichern.

1. Navigieren Sie zu Collections in der Seitenleiste

2. Klicken Sie auf New Collection um eine neue Collection zu erstellen

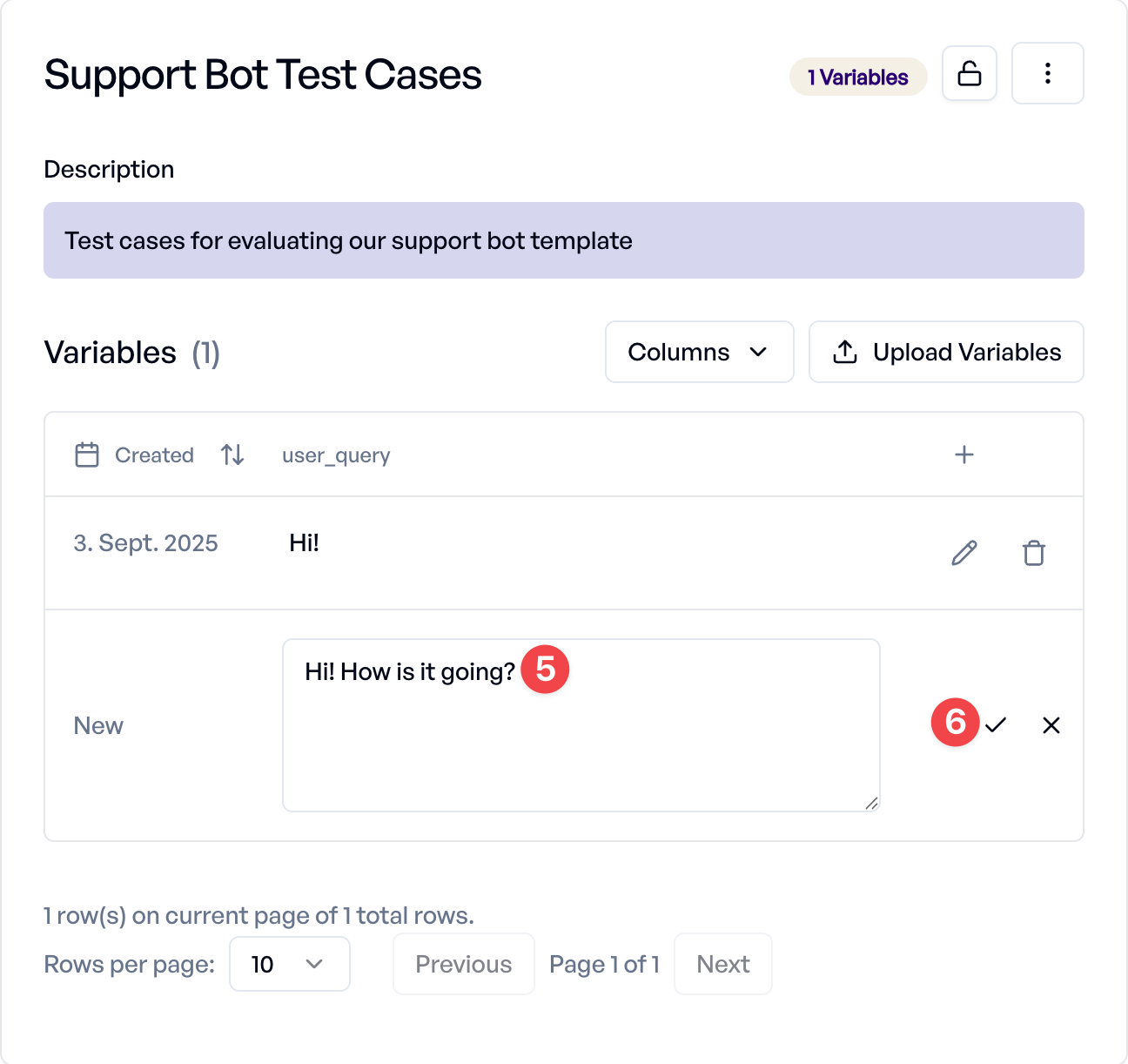

3. Geben Sie den Collection Name ein: "Support Bot Test Cases"

4. Optional fügen Sie eine Description hinzu: "Test cases for evaluating our support bot template"

5. Klicken Sie auf Create Collection um Ihre neue Collection zu speichern

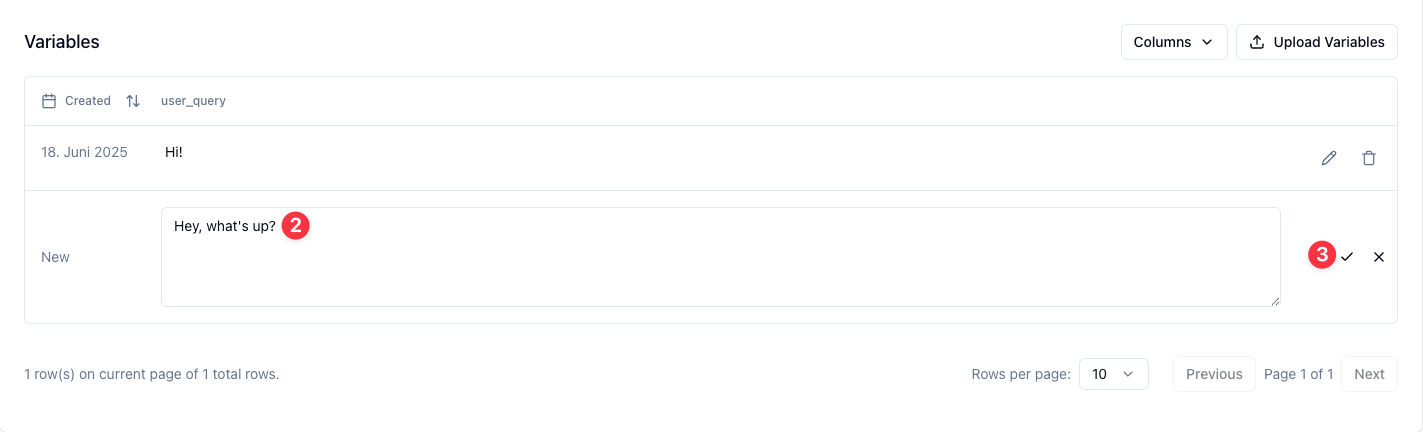

Schritt 7: Template Variable Values hinzufügen¶

Jetzt fügen wir Testfälle hinzu, um unser Prompt Template gründlich zu bewerten.

Zuerst definieren wir die verwendete Template Variable.

1. Klicken Sie auf das Textfeld "Column 1" und benennen Sie es in die Template Variable "user_query" um, die im Prompt Template verwendet wird.

2. Geben Sie einen ersten Wert in das Textfeld unter "Enter value" ein, zum Beispiel "Hi!".

3. Klicken Sie auf das Häkchen rechts um Ihre Änderungen zu speichern.

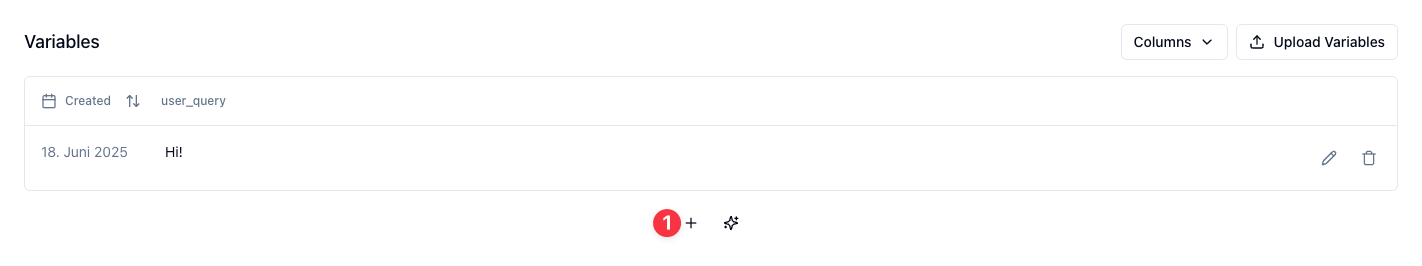

Von hier aus gibt es zwei Möglichkeiten, weitere Werte für Variablen am Ende der Collection hinzuzufügen:

- + Button: Manuell Werte für Variablen einzeln hinzufügen mit vollständiger Kontrolle über jeden Wert

- ✨ (Funken) Button: Werte für Variablen automatisch mit Ihrem Prompt Template und KI generieren

Für dieses Tutorial fügen wir Testfälle manuell hinzu:

4. Klicken Sie auf den + Button um manuell einen Wert hinzuzufügen

5. Fügen Sie einen "user_query" Wert hinzu: "Hi! How is it going?"

6. Klicken Sie auf Save um diesen Wert zu Ihrer Collection hinzuzufügen

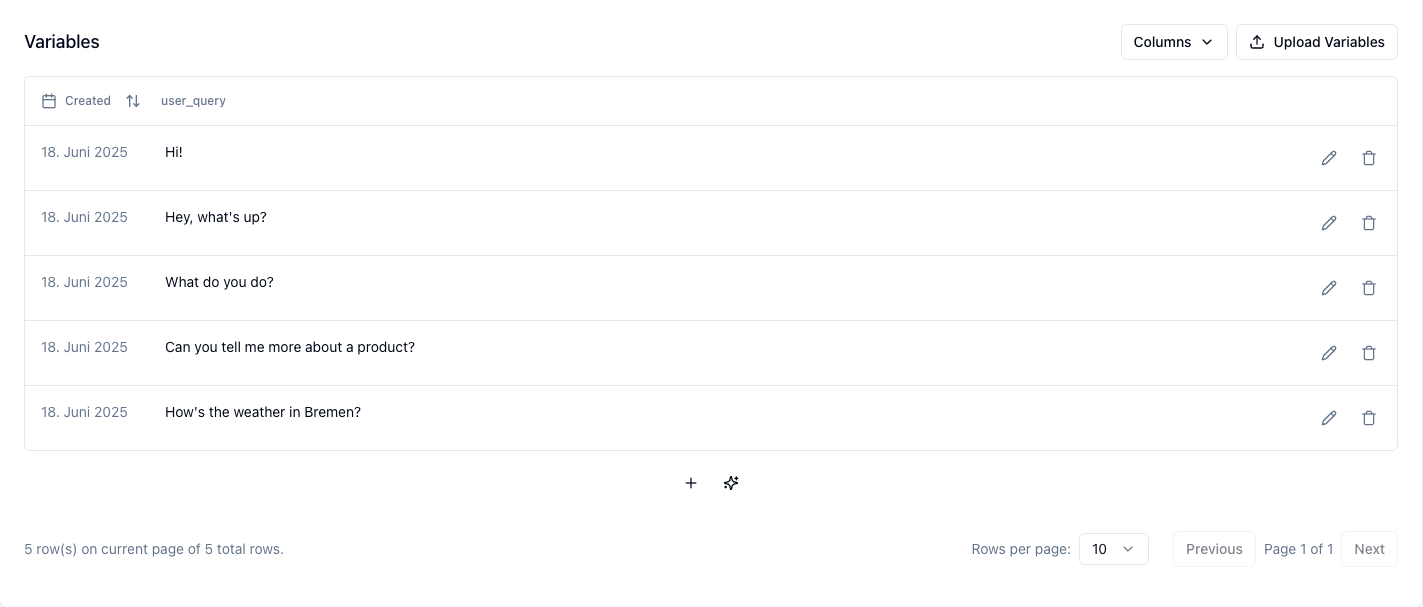

Wiederholen Sie diesen Prozess um weitere User Queries hinzuzufügen und einen umfassenden Testdatensatz aufzubauen:

- What do you do?

- Can you tell me more about a product?

- How's the weather in Bremen?

Schritt 8: Ihr erstes Experiment ausführen¶

Jetzt, da wir alle Komponenten an Ort und Stelle haben (Prompt Template, Bewertungskriterien und Testfälle), führen wir ein vollständiges Experiment aus, um unser Template systematisch zu bewerten.

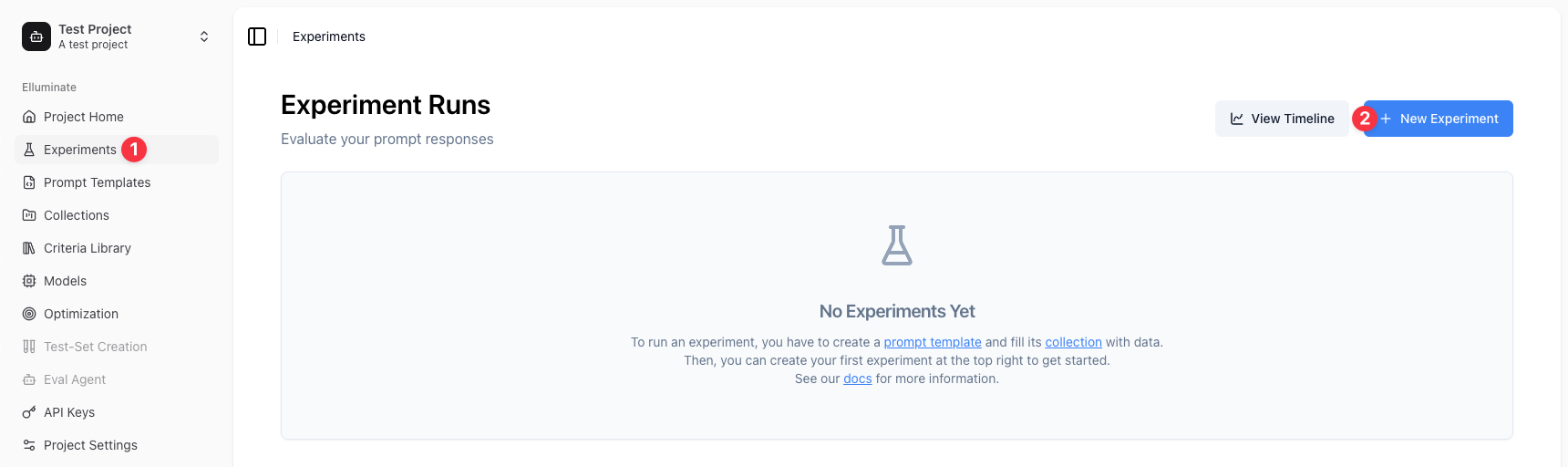

1. Navigieren Sie zu Experiments in der Seitenleiste

2. Klicken Sie auf New Experiment

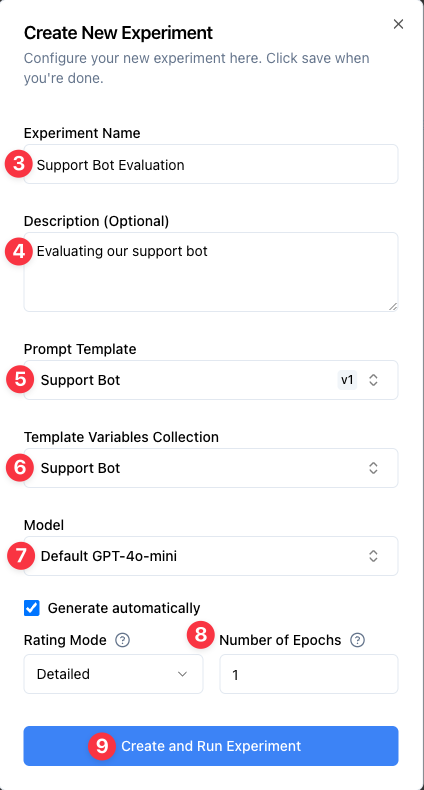

3. Optional geben Sie einen Experiment Name ein: "Support Bot Evaluation" (ein Name wird automatisch generiert, wenn er leer gelassen wird)

4. Fügen Sie eine Description (Optional) hinzu: "Evaluating our support bot"

5. Wählen Sie Ihre Collection: "Support Bot Test Cases"

6. Wählen Sie Ihr Prompt Template: "Support Bot" (v1)

7. Wählen Sie ein Criterion Set. Das mit Ihrem Prompt Template verknüpfte Criterion Set ist standardmäßig ausgewählt, aber Sie können jedes mit Ihrer Collection kompatible Criterion Set wählen

8. Wählen Sie ein Model (z.B. "Default GPT-5")

9. Optional überprüfen Sie die Advanced Settings (behalten Sie die Standardeinstellungen für dieses Tutorial):

- Rating Mode: Detailed mode enthält Begründungen für jedes Kriterium und wird für bessere Interpretierbarkeit empfohlen. Fast mode liefert nur Bewertungen ohne Erklärungen und kann etwas schneller sein.

- Epochs: Epochs ermöglichen es Ihnen, dieselbe Bewertung mehrmals auszuführen. Dies macht die Statistiken zuverlässiger, kann aber einige Zeit dauern.

- Rating Version: Wählen Sie die Rating Model Version aus, die für die Bewertung von Responses verwendet werden soll. Die Standardeinstellung ist die Version aus Ihren Projekteinstellungen.

10. Klicken Sie auf Create and Run Experiment um das Experiment zu starten

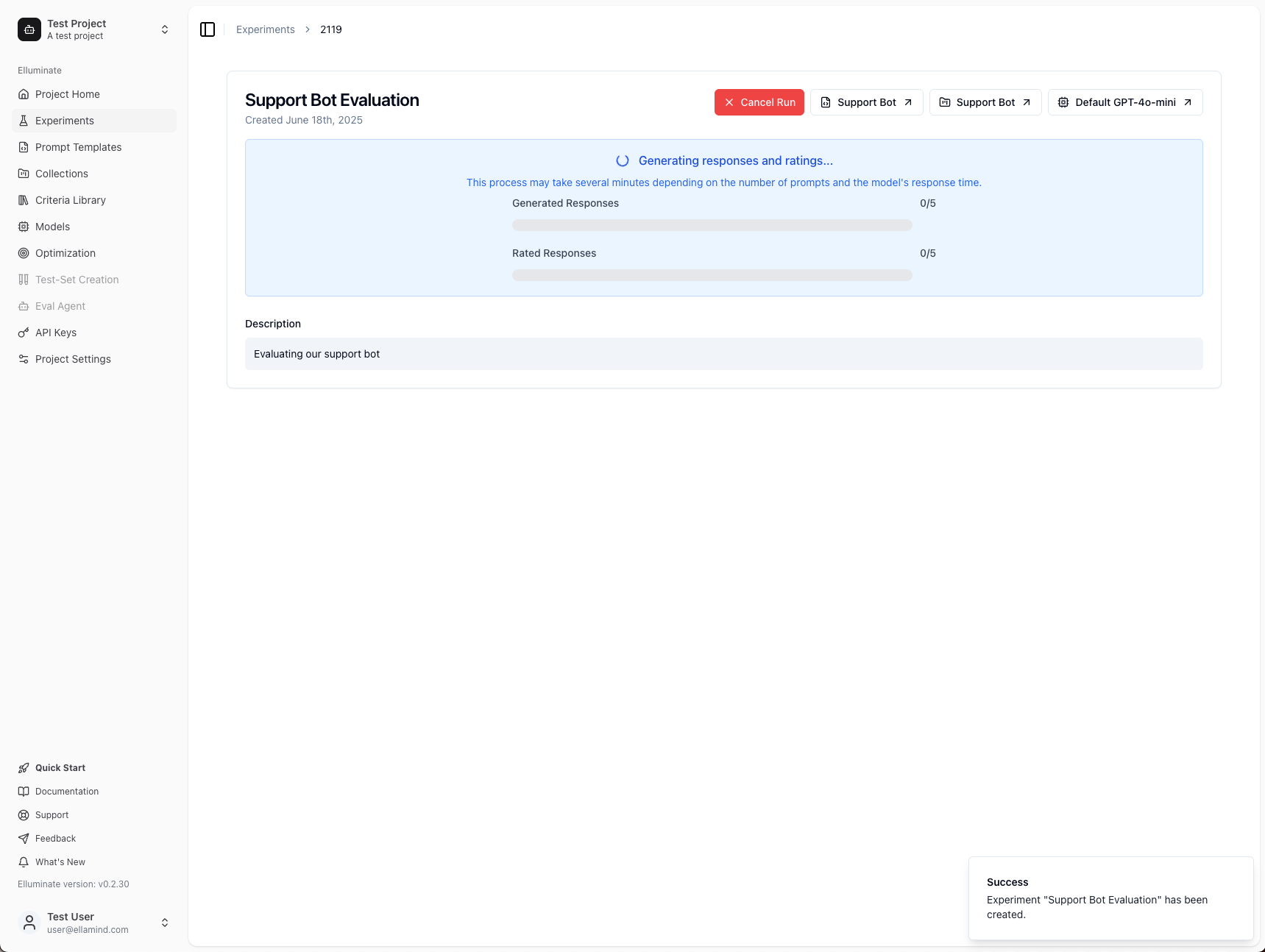

11. Das Experiment wird automatisch Responses für alle Ihre Testfälle generieren und sie basierend auf Ihre Kriterien bewerten

Schritt 9: Ihre Bewertungsergebnisse anzeigen¶

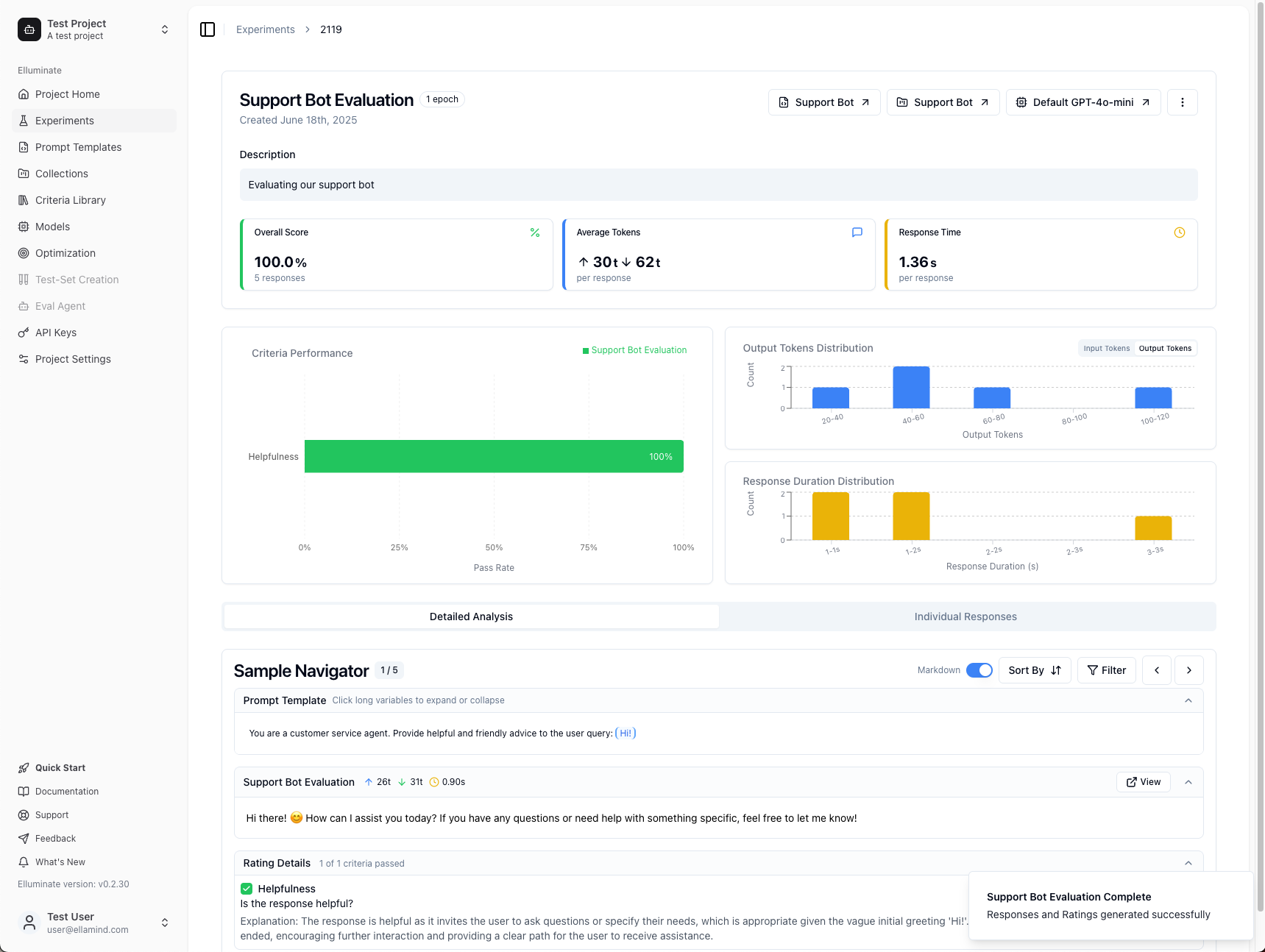

Sobald Ihr Experiment abgeschlossen ist, sehen Sie umfassende Ergebnisse, die zeigen, wie Ihr Prompt Template bei allen Testfällen abgeschnitten hat.

Ihre Ergebnisse verstehen¶

Wichtige Metriken oben:

- Overall Score: Der Prozentsatz der Bewertungskriterien, die bei allen Responses bestanden wurden (in diesem Beispiel: 100%)

- Average Tokens: Zeigt Input Tokens (↑) an, die an das LLM gesendet wurden, und Output Tokens (↓) die in Responses generiert wurden

- Response Time: Durchschnittliche Zeit, die das LLM für die Generierung jeder Response benötigt hat

Kriterienleistung (linke Seite):

Die grünen Balken zeigen, wie gut jedes Bewertungskriterium abgeschnitten hat:

- 100% bedeutet, dass alle Responses dieses spezifische Kriterium bestanden haben

- Niedrigere Prozentsätze zeigen Bereiche an, wo Ihr Prompt verbessert werden könnte

- Verschiedene Kriterien können unterschiedliche Erfolgsraten haben - dies hilft Ihnen zu identifizieren, welche Aspekte Ihres Prompts gut funktionieren und welche verfeinert werden müssen

Verteilungsdiagramme (rechte Seite):

- Output Tokens Distribution: Zeigt die Verteilung der Response-Längen - hilft bei der Identifizierung von Konsistenz

- Response Duration Distribution: Zeigt Timing-Muster - nützlich für Performance-Optimierung

- Interactive Filtering: Klicken Sie auf jeden Balken in diesen Diagrammen, um den Sample Navigator zu filtern und nur Responses in diesem Bereich anzuzeigen

Einzelne Responses analysieren¶

Sample Navigator (unterer Abschnitt):

Dieses leistungsstarke Tool ermöglicht es Ihnen, jeden Testfall im Detail zu untersuchen:

- Navigation: Verwenden Sie die Pfeiltasten oder Tastatur (←→) um durch Ihre Testfälle zu navigieren (der Zähler zeigt Ihre aktuelle Position)

- Markdown Toggle: Wechseln Sie zwischen formatierten und Plain-Text-Ansichten von Responses

- Sort By: Sortieren Sie Ergebnisse nach Bewertung, Token-Anzahl oder Response-Zeit

- Filter: Konzentrieren Sie sich auf spezifische Kriterien oder verstecken Sie perfekte Responses

Zwei Analysemodi:

- Detailed Analysis: Detaillierte Ansicht einzelner Responses mit vollständigem Kontext und Kriterium-für-Kriterium Aufschlüsselung

- Individual Responses: Tabellenansicht, die alle Responses gleichzeitig für schnellen Vergleich anzeigt

Ihre Ergebnisse interpretieren¶

Verwenden Sie diese Ergebnisse, um die Leistung Ihres Prompt Templates zu verstehen:

Wenn Sie hohe Scores sehen (80%+ über alle Kriterien):

- Ihr Prompt Template funktioniert gut

- Erwägen Sie Tests mit herausfordernderen oder vielfältigeren Beispielen

- Sie können dieses Template zuversichtlich für ähnliche Aufgaben verwenden

Wenn Sie gemischte oder niedrigere Scores sehen:

- Schauen Sie sich die Kriterien mit niedrigeren Prozentsätzen an, um Verbesserungsbereiche zu identifizieren

- Verwenden Sie den Sample Navigator um spezifische fehlgeschlagene Fälle zu untersuchen

- Verfeinern Sie Ihr Prompt Template basierend auf häufigen Fehlermustern

- Führen Sie zusätzliche Experimente aus, um Ihre Verbesserungen zu testen

Wichtig für alle Ergebnisse:

- Überprüfen Sie zufällige bestandene Samples - Auch wenn Responses Ihre Kriterien bestehen, untersuchen Sie eine zufällige Stichprobe, um sicherzustellen, dass Ihre Bewertungskriterien mit dem übereinstimmen, was Sie tatsächlich als erfolgreich betrachten

- Dies hilft sicherzustellen, dass Ihre Kriterien nicht zu nachsichtig sind oder wichtige Qualitätsaspekte verpassen

Ihre Bewertung erweitern:

Unabhängig von Ihren anfänglichen Ergebnissen, hier sind Möglichkeiten, Ihren Bewertungsprozess zu verbessern:

- Probieren Sie verschiedene LLM-Konfigurationen aus, um die Leistung zu vergleichen

- Fügen Sie vielfältigere Testfälle hinzu, um Ihr Template gründlich zu testen

- Experimentieren Sie mit verschiedenen Bewertungskriterien, um andere Qualitätsaspekte zu erfassen

Nächste Schritte¶

Jetzt, da Sie Ihre erste Bewertung über die Web-Oberfläche abgeschlossen haben:

- Richten Sie Experiment Schedules ein, um automatisch Bewertungen in regelmäßigen Abständen auszuführen und benachrichtigt zu werden, wenn die Leistung nachlässt

- Folgen Sie unserem SDK Quick Start um zu lernen, wie Sie dieselben Workflows mit der elluminate CLI und Python SDK ausführen

- Erkunden Sie Experiments um systematische Bewertungen durchzuführen

- Lernen Sie über Criterion Sets um benutzerdefinierte Bewertungskriterien zu erstellen

- Probieren Sie Batch Processing aus, um mehrere Responses gleichzeitig zu bewerten

- Verstehen Sie Key Concepts für einen tieferen Einblick in elluminate's Features

Was Sie erreicht haben¶

- ✅ Ein Prompt Template mit Platzhaltern erstellt

- ✅ Ihr Template mit dem Response Generator getestet

- ✅ Bewertungskriterien manuell hinzugefügt

- ✅ Eine Template Variables Collection mit Testfällen erstellt

- ✅ Zusätzliche Testvariablen manuell hinzugefügt

- ✅ Ein vollständiges Experiment mit systematischer Bewertung ausgeführt

- ✅ Umfassende Ergebnisse mit fortgeschrittenen Tools analysiert

- ✅ Gelernt, Performance-Metriken und Verteilungen zu interpretieren

Sie sind jetzt bereit, Ihre Bewertungs-Workflows mit elluminate zu skalieren!

Support¶

Wenn Sie Hilfe mit der elluminate Plattform benötigen, kontaktieren Sie uns per E-Mail unter [email protected].