Schnellstart (SDK)¶

Beginnen Sie in wenigen Minuten mit der Bewertung von Prompts mit dem Python SDK

Für ein tieferes Verständnis der Plattform schauen Sie in unsere Grundkonzepte und Erweiterte Leitfäden.

Async-Unterstützung

Das SDK bietet sowohl synchrone (Client) als auch asynchrone (AsyncClient) Clients mit identischen APIs. Dieser Schnellstart verwendet den synchronen Client. Für asynchrone Operationen, gleichzeitige Ausführung und Echtzeit-Streaming siehe den Async Operations Guide.

Anforderungen¶

Das elluminate SDK benötigt:

- Python: 3.10 oder höher

Überprüfen Sie Ihre Python-Version:

Voraussetzungen¶

Installieren Sie zunächst das elluminate-Paket und ein zusätzliches Paket, das für den Quickstart-Code erforderlich ist:

Als nächstes müssen Sie Ihren API-Schlüssel einrichten. Besuchen Sie die "API Keys"-Seite Ihres Projekts, um einen neuen API-Schlüssel zu erstellen. Detaillierte Informationen zur API-Schlüssel-Verwaltung und zu Sicherheits-Best-Practices finden Sie in unserem API Key Management Handbuch.

Sobald Sie Ihren API-Schlüssel haben, exportieren Sie ihn und die Service-Adresse als Umgebungsvariablen:

export ELLUMINATE_API_KEY=<your_api_key>

export ELLUMINATE_BASE_URL=<your_elluminate_service_address>

Denken Sie daran, Ihren API-Schlüssel sicher zu speichern und niemals in die Versionskontrolle zu übertragen. Sie sind jetzt bereit, mit der Evaluierung von Prompts mit elluminate zu beginnen!

Jupyter Notebook¶

Wenn Sie ein Jupyter Notebook verwenden, installieren Sie die erforderlichen Pakete und definieren Sie die Umgebungsvariablen wie folgt:

!pip install elluminate nest-asyncio python-dotenv

%env ELLUMINATE_API_KEY=<your_api_key>

%env ELLUMINATE_BASE_URL=<your_elluminate_service_address>

Bevor Sie den Quickstart-Code ausführen, führen Sie diese Zeilen für die Jupyter Notebook-Kompatibilität aus:

Ihren ersten Prompt bewerten¶

Implementieren Sie Ihre erste Evaluation mit dem folgenden Python-Code:

-

Initialisiert den elluminate-Client mit Ihren konfigurierten Umgebungsvariablen aus der Setup-Phase.

-

Erstellt ein Prompt-Template mit Mustache-Syntax, die Template-Variablen einbindet (wie

conceptin diesem Beispiel). Wenn die Vorlage bereits existiert, wird sie einfach zurückgegeben. -

Generiert Bewertungskriterien automatisch für Ihr Prompt-Template oder holt die bestehenden Kriterien.

-

Erstellt eine Template-Variables-Collection. Diese wird verwendet, um die Template-Variablen für ein Prompt-Template zu sammeln.

-

Fügt eine Template-Variable zur Collection hinzu. Diese wird verwendet, um die Template-Variable zu füllen (

recursionzur Spalteconcepthinzuzufügen). -

Erstellt eine Response, indem Ihre Prompt-Template verwendet und die Template-Variable ausgefüllt wird.

-

Bewertet die Response anhand der generierten Kriterien und gibt detaillierte Bewertungen für jedes Kriterium zurück.

Die Bewertungen anzeigen¶

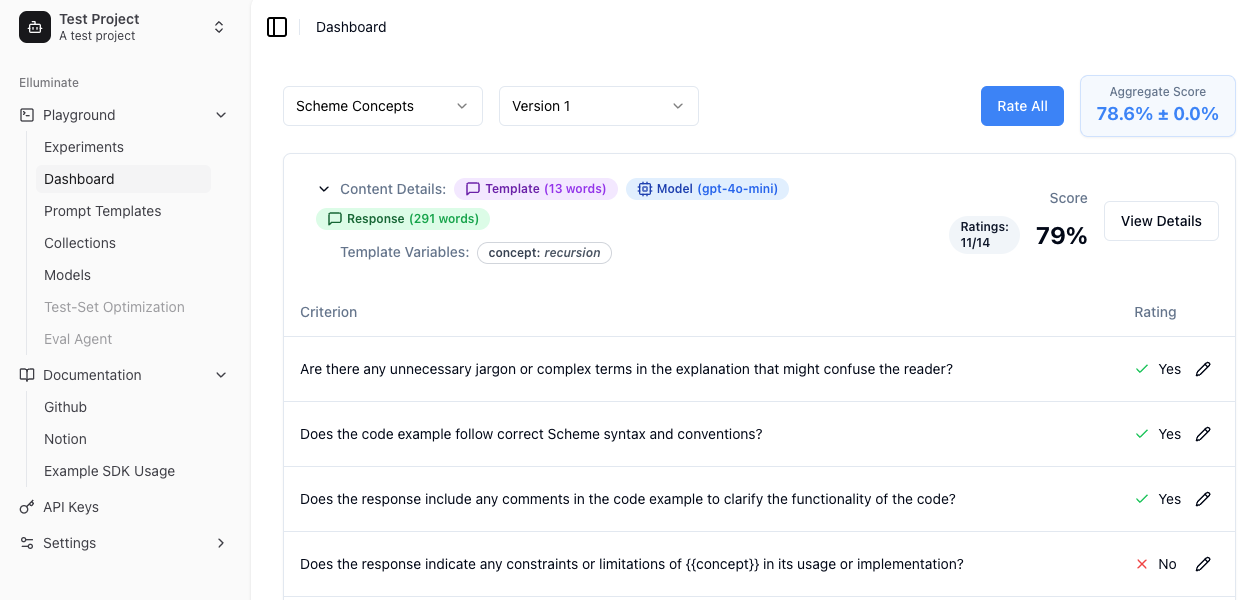

Greifen Sie auf Ihre Bewertungen über die Weboberfläche zu, indem Sie sich anmelden. Bei der Ansicht Ihres Bewertungs-Dashboards finden Sie eine umfassende Übersicht mit wichtigen Statistiken wie:

- Gesammtperformance (Overall Score)

- Tokenanzahl für Prompt-Templates und Antworten

- Anzahl der verwendeten Bewertungskriterien

Jeder Bewertungseintrag kann erweitert werden, um detaillierte Informationen zu zeigen, einschließlich spezifischer Bewertungskriterien und ob jedes Kriterium erfolgreich erfüllt wurde. Diese detaillierte Ansicht hilft Ihnen zu verstehen, wie Ihre Antworten bewertet wurden.

Nächste Schritte¶

- Erkunden Sie die Grundkonzepte von elluminate

- Lernen Sie über Async Operations für gleichzeitige Ausführung und Echtzeit-Streaming

- Schauen Sie sich Batch Processing für effiziente Operationen an